IMA4 2018/2019 P30 : Différence entre versions

(→Docker comparé à Rkt) |

(→Documents Rendus) |

||

| (139 révisions intermédiaires par le même utilisateur non affichées) | |||

| Ligne 19 : | Ligne 19 : | ||

# La taille : En effet un conteneur prend quelques dizaines de mégaoctets de taille, contrairement à une VM qui peut prendre plusieurs Gigabytes à cause de son système d'exploitation.Ce qui rend l'utilisation des conteneurs très populaire sur les serveurs qui peuvent en contenir plusieurs. Et dans le cloud où l'on paie ce qu'on consomme. | # La taille : En effet un conteneur prend quelques dizaines de mégaoctets de taille, contrairement à une VM qui peut prendre plusieurs Gigabytes à cause de son système d'exploitation.Ce qui rend l'utilisation des conteneurs très populaire sur les serveurs qui peuvent en contenir plusieurs. Et dans le cloud où l'on paie ce qu'on consomme. | ||

| − | # Le temps : Une application conteneurisée peut être démarrée instantanément et quand il est nécessaire peut disparaître libérant des ressources sur son hôte tandis que les machines virtuelles peuvent prendre plusieurs minutes pour démarrer leurs systèmes d'exploitation et commencer à exécuter les applications qu' | + | # Le temps : Une application conteneurisée peut être démarrée instantanément et quand il est nécessaire peut disparaître libérant des ressources sur son hôte tandis que les machines virtuelles peuvent prendre plusieurs minutes pour démarrer leurs systèmes d'exploitation et commencer à exécuter les applications qu'elles hébergent. |

| − | #La modularité : Plutôt que d'exécuter une application complexe entière dans un seul conteneur, l'application peut être divisée en modules (tels que la base de données, l'interface | + | #La modularité : Plutôt que d'exécuter une application complexe entière dans un seul conteneur, l'application peut être divisée en modules (tels que la base de données, l'interface de l'application, etc.) Les applications créées de cette manière sont plus faciles à gérer car chaque module est relativement simple et des modifications peuvent être apportées aux modules sans avoir à reconstruire l'application entière. Étant donné que les conteneurs sont si légers, les modules individuels (ou micro services) ne peuvent être instanciés que lorsqu'ils sont nécessaires et sont disponibles presque immédiatement. |

Avec une telle architecture, on suit la philosophie UNIX du “KISS” | Avec une telle architecture, on suit la philosophie UNIX du “KISS” | ||

* Les applications n’ont pas de dépendance système. | * Les applications n’ont pas de dépendance système. | ||

* Les mises à jours sont déployables facilement. | * Les mises à jours sont déployables facilement. | ||

| − | * La consommation de ressources est | + | * La consommation de ressources est optimisée. |

Les containers sont donc proches des machines virtuelles, mais présentent des avantages importants. | Les containers sont donc proches des machines virtuelles, mais présentent des avantages importants. | ||

| Ligne 47 : | Ligne 47 : | ||

*Un contrôle des instances se fera par "crontab" et les instances seront connectées via des commutateurs virtuels Linux classiques. | *Un contrôle des instances se fera par "crontab" et les instances seront connectées via des commutateurs virtuels Linux classiques. | ||

*La gestion sophistiquée des images à base de système de fichiers à couche n'est pas permise. | *La gestion sophistiquée des images à base de système de fichiers à couche n'est pas permise. | ||

| − | *Avant de lancer un conteneur le système de fichiers (un fichier lui-même) sera copié et le conteneur sera démarré sur la copie. | + | *Avant de lancer un conteneur, le système de fichiers (un fichier lui-même) sera copié et le conteneur sera démarré sur la copie. |

=Analyse du projet= | =Analyse du projet= | ||

| Ligne 57 : | Ligne 57 : | ||

==Analyse du premier concurrent== | ==Analyse du premier concurrent== | ||

[[Fichier:Docker_logo.jpg|200px|thumb|right|Docker]] | [[Fichier:Docker_logo.jpg|200px|thumb|right|Docker]] | ||

| − | Docker Enterprise Edition est sans doute la solution de gestion de conteneurs commerciale la plus connue. Il fournit une plate-forme intégrée, testée et certifiée pour les applications exécutées sur les systèmes d'exploitation Linux ou Windows et les fournisseurs de cloud. L’écosystème de Docker est riche et complet, cela va de la gestion de conteneurs, à l’orchestration (Docker Swarm ou son concurrent Google Kubernetes) tout en passant par la gestion du réseau, de l’intégration du cloud avec Docker machine, des | + | Docker Enterprise Edition est sans doute la solution de gestion de conteneurs commerciale la plus connue. Il fournit une plate-forme intégrée, testée et certifiée pour les applications exécutées sur les systèmes d'exploitation Linux ou Windows et les fournisseurs de cloud. L’écosystème de Docker est riche et complet, cela va de la gestion de conteneurs, à l’orchestration (Docker Swarm ou son concurrent Google Kubernetes) tout en passant par la gestion du réseau, de l’intégration du cloud avec Docker machine, des applications multi conteneurs avec Docker Compose. |

Aujourd’hui, selon les créateurs de Docker, plus de 3,5 millions d’applications ont été containérisées en utilisant cette technologie, et plus de 37 milliards d’applications containérisées ont été téléchargées. | Aujourd’hui, selon les créateurs de Docker, plus de 3,5 millions d’applications ont été containérisées en utilisant cette technologie, et plus de 37 milliards d’applications containérisées ont été téléchargées. | ||

| Ligne 66 : | Ligne 66 : | ||

[[Fichier:rocket.jpg|200px|thumb|left|Rocket]] | [[Fichier:rocket.jpg|200px|thumb|left|Rocket]] | ||

Rocket (rkt) est un outil édité par CoreOS et est le concurrent de Docker. | Rocket (rkt) est un outil édité par CoreOS et est le concurrent de Docker. | ||

| − | + | C'est un moteur de conteneur d'application développé pour les environnements de production modernes basés sur le cloud. Il présente une approche pod-native, un environnement d’exécution enfichable et une surface bien définie qui le rend idéal pour une intégration avec d’autres systèmes. | |

| − | L'unité d'exécution principale de rkt est le "pod": un ensemble d'une ou plusieurs applications s'exécutant dans un contexte partagé (les pods de rkt sont synonymes du concept du système d'orchestration Kubernetes). Rkt permet aux utilisateurs d'appliquer différentes configurations (telles que les paramètres d'isolation) au niveau du pod et au niveau plus granulaire par application. L’architecture de rkt signifie que chaque pod s’exécute directement dans le modèle de processus Unix classique (c’est-à-dire qu’il | + | L'unité d'exécution principale de rkt est le "pod": un ensemble d'une ou plusieurs applications s'exécutant dans un contexte partagé (les pods de rkt sont synonymes du concept du système d'orchestration Kubernetes). Rkt permet aux utilisateurs d'appliquer différentes configurations (telles que les paramètres d'isolation) au niveau du pod et au niveau plus granulaire par application. L’architecture de rkt signifie que chaque pod s’exécute directement dans le modèle de processus Unix classique (c’est-à-dire qu’il n’y a pas de démon central), dans un environnement isolé et autonome. rkt implémente un format de conteneur standard moderne et ouvert, la spécification App Container (appc), mais peut également exécuter d'autres images de conteneur, telles que celles créées avec Docker. |

Depuis son introduction par CoreOS en décembre 2014, le projet rkt a considérablement mûri et est largement utilisé. Il est disponible pour la plupart des principales distributions Linux et chaque version de rkt construit des packages rpm / deb autonomes que les utilisateurs peuvent installer. Ces packages sont également disponibles dans le référentiel Kubernetes pour permettre de tester l'intégration rkt + Kubernetes. rkt joue également un rôle central dans la manière dont Google Container Image et CoreOS Container Linux exécutent Kubernetes. | Depuis son introduction par CoreOS en décembre 2014, le projet rkt a considérablement mûri et est largement utilisé. Il est disponible pour la plupart des principales distributions Linux et chaque version de rkt construit des packages rpm / deb autonomes que les utilisateurs peuvent installer. Ces packages sont également disponibles dans le référentiel Kubernetes pour permettre de tester l'intégration rkt + Kubernetes. rkt joue également un rôle central dans la manière dont Google Container Image et CoreOS Container Linux exécutent Kubernetes. | ||

Les éditeurs se concentrent sur la sécurité (le plus gros point faible de Docker), la compatibilité et une intégration aux standards. | Les éditeurs se concentrent sur la sécurité (le plus gros point faible de Docker), la compatibilité et une intégration aux standards. | ||

| − | Le but étant de fournir les mêmes fonctionnalités que docker et être | + | Le but étant de fournir les mêmes fonctionnalités que docker et être complémentaire. |

==Docker comparé à Rkt== | ==Docker comparé à Rkt== | ||

| Ligne 82 : | Ligne 82 : | ||

*Prévention des attaques d'élévation de privilèges «root» | *Prévention des attaques d'élévation de privilèges «root» | ||

Docker s'exécute avec les privilèges de super-utilisateur «root» et crée de nouveaux conteneurs en tant que sous-processus. Le problème avec cela est qu'une vulnérabilité dans un conteneur ou un confinement médiocre peut donner à un attaquant un accès de niveau racine au serveur entier. | Docker s'exécute avec les privilèges de super-utilisateur «root» et crée de nouveaux conteneurs en tant que sous-processus. Le problème avec cela est qu'une vulnérabilité dans un conteneur ou un confinement médiocre peut donner à un attaquant un accès de niveau racine au serveur entier. | ||

| − | Rkt a proposé une meilleure solution: les nouveaux conteneurs ne sont jamais créés à partir d'un processus root. De cette manière, même si une rupture de conteneur se produit, l'attaquant ne peut pas obtenir les privilèges root. | + | Rkt a proposé une meilleure solution: les nouveaux conteneurs ne sont jamais créés à partir d'un processus root. De cette manière, même si une rupture de conteneur se produit, l'attaquant ne peut pas obtenir les privilèges root. |

| + | *Flexibilité dans la publication ou le partage d'images | ||

Lors du développement d'applications, il peut être nécessaire de partager des images de conteneur avec vos partenaires technologiques. Si vous souhaitez partager des conteneurs Docker, vous devez configurer un registre privé spécial sur vos serveurs ou l'héberger dans un compte payant Docker pour le partager avec vos partenaires. | Lors du développement d'applications, il peut être nécessaire de partager des images de conteneur avec vos partenaires technologiques. Si vous souhaitez partager des conteneurs Docker, vous devez configurer un registre privé spécial sur vos serveurs ou l'héberger dans un compte payant Docker pour le partager avec vos partenaires. | ||

Pour rkt, vous n’avez besoin que de votre serveur Web. Rkt utilise le protocole HTTPS pour télécharger des images et utilise une méta-description sur le serveur Web pour pointer vers l'emplacement. C’est donc un serveur de moins à maintenir et plus facile à accéder pour les partenaires. | Pour rkt, vous n’avez besoin que de votre serveur Web. Rkt utilise le protocole HTTPS pour télécharger des images et utilise une méta-description sur le serveur Web pour pointer vers l'emplacement. C’est donc un serveur de moins à maintenir et plus facile à accéder pour les partenaires. | ||

*Taille de la base de code | *Taille de la base de code | ||

Docker ajoute toutes ses fonctionnalités à un seul fichier programme monolithique, ce qui signifie que le nombre de lignes de code ne cesse d’augmenter à chaque nouvelle version. Et voici un problème de sécurité. Une seule vulnérabilité dans l'une des milliers de lignes de code peut compromettre l'intégralité du programme et donner essentiellement un accès root à un attaquant. | Docker ajoute toutes ses fonctionnalités à un seul fichier programme monolithique, ce qui signifie que le nombre de lignes de code ne cesse d’augmenter à chaque nouvelle version. Et voici un problème de sécurité. Une seule vulnérabilité dans l'une des milliers de lignes de code peut compromettre l'intégralité du programme et donner essentiellement un accès root à un attaquant. | ||

| − | Au contraire, rkt utilise | + | Au contraire, rkt utilise une architecture modulaire dans laquelle les fonctionnalités sont développées sous forme de fichiers binaires indépendants par différents fournisseurs. Le code de base est maintenu aussi petit que possible afin de réduire la surface d'attaque. Cela garantit que même si un sous-composant tel que etcd est compromis, les dommages seraient limités aux données auxquelles ce programme peut accéder. |

*Portabilité à d'autres systèmes de conteneurs | *Portabilité à d'autres systèmes de conteneurs | ||

| − | De nouveaux systèmes de conteneurs sortent tout le temps. Avec Docker, la migration vers une nouvelle technologie de conteneur peut poser problème, car | + | De nouveaux systèmes de conteneurs sortent tout le temps. Avec Docker, la migration vers une nouvelle technologie de conteneur peut poser problème, car il utilise un format d’image propriétaire. |

En revanche, rkt utilise un format de conteneur open source appelé «appc». Ainsi, toute image de serveur créée à l'aide de rkt peut être facilement portée vers un autre système de conteneur à condition qu'elle suive le format ouvert «appc». | En revanche, rkt utilise un format de conteneur open source appelé «appc». Ainsi, toute image de serveur créée à l'aide de rkt peut être facilement portée vers un autre système de conteneur à condition qu'elle suive le format ouvert «appc». | ||

En adhérant à un standard ouvert, rkt n’impose pas de verrouillage du fournisseur. Cela aide les propriétaires de système à migrer sans peine vers un autre système de conteneur mieux adapté à leurs besoins. | En adhérant à un standard ouvert, rkt n’impose pas de verrouillage du fournisseur. Cela aide les propriétaires de système à migrer sans peine vers un autre système de conteneur mieux adapté à leurs besoins. | ||

| Ligne 118 : | Ligne 119 : | ||

L'autre inconvénient de Docker c'est qu'il va manipuler les Iptables [https://docs.docker.com/network/iptables/] afin de pouvoir gérer le réseau des conteneurs, cela peut venir perturber les configurations réseaux déjà présentes sur la machine. Mon système n'utilisera que les commutateurs logiciels (bridges linux) standards. Ainsi, il n'y aura aucune altération du routage des paquets au sein de la machine. | L'autre inconvénient de Docker c'est qu'il va manipuler les Iptables [https://docs.docker.com/network/iptables/] afin de pouvoir gérer le réseau des conteneurs, cela peut venir perturber les configurations réseaux déjà présentes sur la machine. Mon système n'utilisera que les commutateurs logiciels (bridges linux) standards. Ainsi, il n'y aura aucune altération du routage des paquets au sein de la machine. | ||

| − | De plus je n'utiliserai pas de gestion sophistiquée des images à base de système de fichiers à couche. Avant de lancer un conteneur le système de fichiers (un fichier lui-même) est copié, et le conteneur est démarré sur cette copie. | + | De plus, je n'utiliserai pas de gestion sophistiquée des images à base de système de fichiers à couche. Avant de lancer un conteneur, le système de fichiers (un fichier lui-même) est copié, et le conteneur est démarré sur cette copie. |

=Préparation du projet= | =Préparation du projet= | ||

| Ligne 127 : | Ligne 128 : | ||

<ul> | <ul> | ||

| − | <li>Commencer par faire un état de l'art afin de me forger des connaissances solides sur les conteneurs et | + | <li>Commencer par faire un état de l'art afin de me forger des connaissances solides sur les conteneurs et leur orchestration.</li> |

<li>Créer, configurer et supprimer des conteneurs "à la main".</li> | <li>Créer, configurer et supprimer des conteneurs "à la main".</li> | ||

<li>Créer un programme shell (qu'on lance dans le contexte d'un conteneur) qui permet d'automatiser la gestion des conteneurs, pour :</li> | <li>Créer un programme shell (qu'on lance dans le contexte d'un conteneur) qui permet d'automatiser la gestion des conteneurs, pour :</li> | ||

| Ligne 144 : | Ligne 145 : | ||

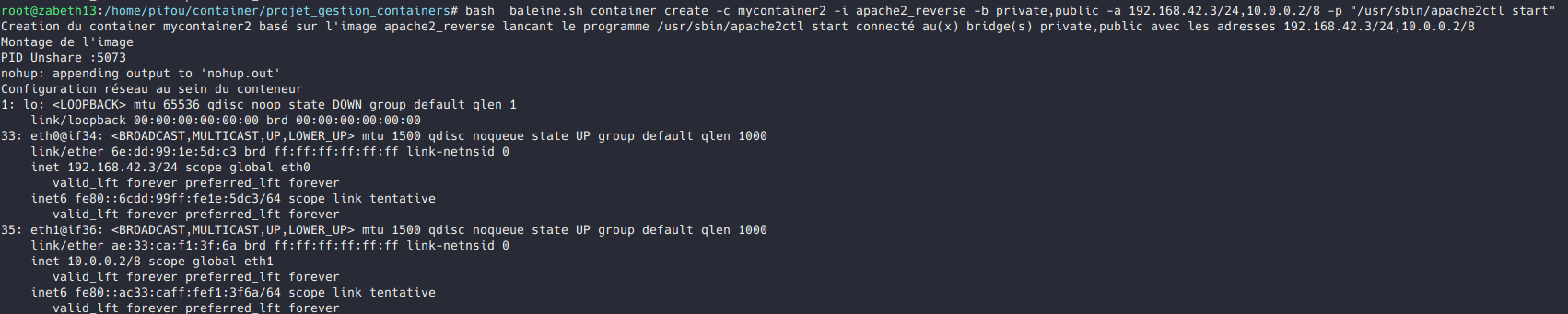

L'objectif est de créer un programme qui se présentera comme suit (on le nommera baleine) : | L'objectif est de créer un programme qui se présentera comme suit (on le nommera baleine) : | ||

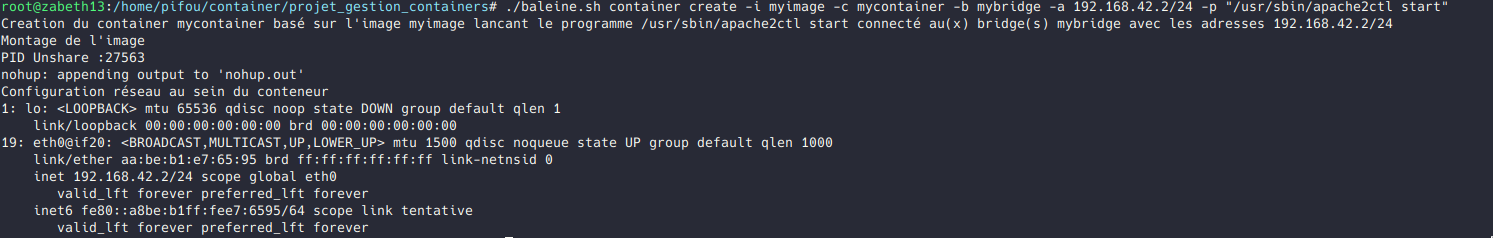

| − | *Crée un nouveau conteneur ( | + | *Crée un nouveau conteneur (lui ajouter des contraintes avec les cgroups, ajouter le bridge auquel l'ajouter ainsi que son adresse ip) : |

baleine container create | baleine container create | ||

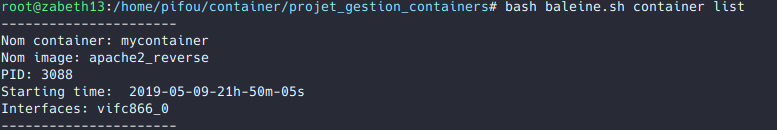

*Retourne la liste des conteneurs qui tournent sur le système, avec leurs adresses ip, leurs limitations cgroups, etc | *Retourne la liste des conteneurs qui tournent sur le système, avec leurs adresses ip, leurs limitations cgroups, etc | ||

baleine container list | baleine container list | ||

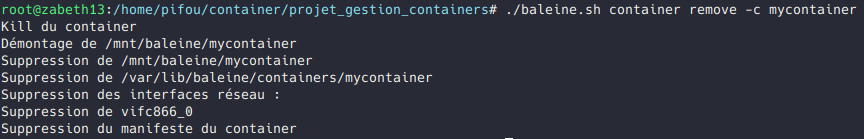

| − | * | + | *Supprimer un conteneur : |

| − | baleine container | + | baleine container remove |

| + | *Stopper le conteneur : | ||

| + | baleine container stop | ||

| + | *Redémarrer un conteneur: | ||

| + | baleine container restart | ||

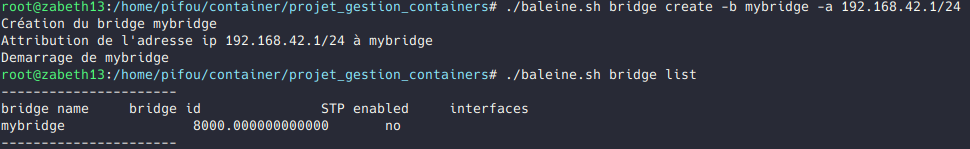

*Crée un nouveau pont (bridge) linux afin d'interconnecter les containers | *Crée un nouveau pont (bridge) linux afin d'interconnecter les containers | ||

| − | baleine | + | baleine bridge create |

*Renvoie la liste des ponts linux ainsi que le nombre de containers connectés dessus | *Renvoie la liste des ponts linux ainsi que le nombre de containers connectés dessus | ||

| − | baleine | + | baleine bridge list |

*Crée une nouvelle image avec la taille indiquée | *Crée une nouvelle image avec la taille indiquée | ||

baleine image create | baleine image create | ||

| Ligne 163 : | Ligne 168 : | ||

baleine image export | baleine image export | ||

Afin de lister les conteneurs, les images, et les bridges, il sera nécessaire de les stocker dans un fichier. | Afin de lister les conteneurs, les images, et les bridges, il sera nécessaire de les stocker dans un fichier. | ||

| − | Pour les conteneurs, ce fichier sera /var/lib/baleine/containers. | + | Pour les conteneurs, ce fichier sera /var/lib/baleine/manifeste/containers/nom_conteneur.manifest, il se présentera sous la forme : |

| − | + | nom_container: | |

| − | Pour les images, ce fichier sera /var/lib/baleine/images. | + | nom_image: |

| − | + | pid: | |

| − | Pour les bridges, ce fichier sera /var/lib/baleine/bridges. | + | nom_bridge: |

| − | + | starting_time: | |

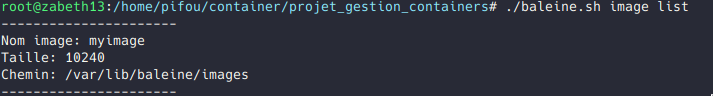

| + | Pour les images, ce fichier sera /var/lib/baleine/manifeste/images/nom_image.manifest, il se présentera sous la forme : | ||

| + | nom_image: | ||

| + | taille: | ||

| + | chemin: | ||

| + | Pour les bridges, ce fichier sera /var/lib/baleine/manifeste/bridges/nom_bridge.manifest, il se présentera sous la forme : | ||

| + | nom_bridge: | ||

==Choix techniques : matériel et logiciel== | ==Choix techniques : matériel et logiciel== | ||

| − | Ce projet est purement informatique, il ne nécessite aucun matériel. Par contre au moment où je ferai l'infrastructure avec les conteneurs, j'aurai besoin d'un serveur ainsi qu'une machine virtuelle. | + | Ce projet est purement informatique, il ne nécessite aucun matériel. Par contre, au moment où je ferai l'infrastructure avec les conteneurs, j'aurai besoin d'un serveur ainsi qu'une machine virtuelle. |

==Liste des tâches à effectuer== | ==Liste des tâches à effectuer== | ||

| Ligne 189 : | Ligne 200 : | ||

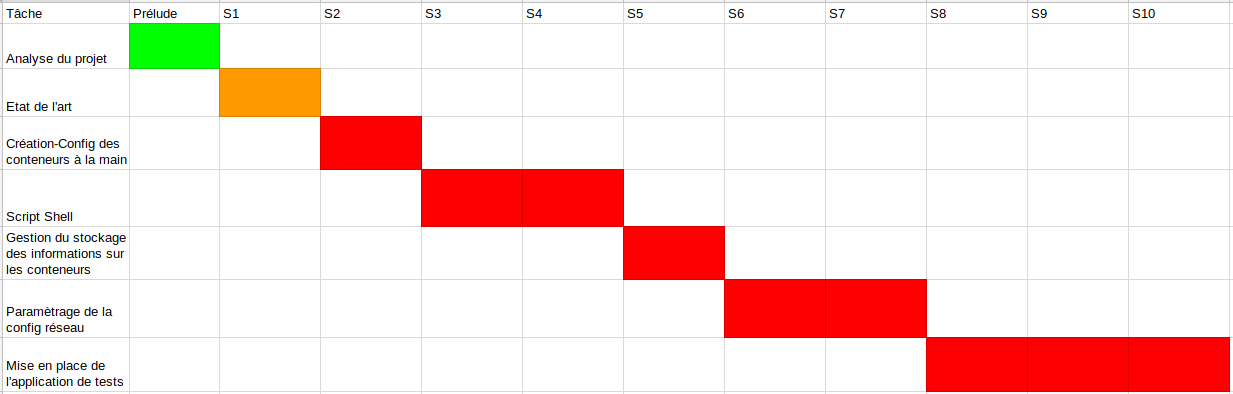

==Calendrier prévisionnel== | ==Calendrier prévisionnel== | ||

| − | Le projet étant à rendre au mois de Mai, prenant en compte une marge d' | + | Le projet étant à rendre au mois de Mai, prenant en compte une marge d'erreur et d'amélioration éventuelle, le calendrier prévisionnel optimal que je me suis fixée se trouve sur le diagramme de Gantt suivant : |

[[Fichier:Gantt_prévisionnel.png]] | [[Fichier:Gantt_prévisionnel.png]] | ||

=Réalisation du Projet= | =Réalisation du Projet= | ||

==Feuille d'heures== | ==Feuille d'heures== | ||

| + | |||

| + | Cette feuille d'heures a été faite approximativement. En effet, ayant apprécié le sujet, j'y ai consacré un temps sans vraiment compter, et j'aurai voulu aller plus loin pour répondre à toutes les consignes du cahier des charges. | ||

{| class="wikitable" | {| class="wikitable" | ||

!Tâche !! Prélude !! Heures S1 !! Heures S2 !! Heures S3 !! Heures S4 !! Heures S5 !! Heures S6 !! Heures S7 !! Heures S8 !! Heures S9 !! Heures S10 !! Total | !Tâche !! Prélude !! Heures S1 !! Heures S2 !! Heures S3 !! Heures S4 !! Heures S5 !! Heures S6 !! Heures S7 !! Heures S8 !! Heures S9 !! Heures S10 !! Total | ||

|- | |- | ||

| − | | Analyse du projet || 10 || || || || || || || || || || | + | | Analyse du projet || 10 || || || || || || || || || || ||10 |

| − | | | ||

|- | |- | ||

| − | | | + | |État de l'art || 2|| 8 || || || ||2 ||3 || || || || || 15 |

| + | |- | ||

| + | |Création-configuration des conteneurs à la main || || ||6 || 5|| 4|| || || || || || || 15 | ||

| + | |- | ||

| + | |Configuration des interfaces et création du bridge|| || |||| || || 6|| || || || || || 6 | ||

| + | |- | ||

| + | |Script Shell|| || || || || || ||8 ||4 ||3 ||2 ||4|| 21 | ||

|- | |- | ||

| − | | | + | |Gestion du stockage des informations des conteneurs || || || || || || || || ||6 || || || 6 |

|- | |- | ||

| − | | | + | |Paramétrage de la configuration réseau|| || || || || || | || || || || 8|| || 8 |

|- | |- | ||

| − | | | + | |Mise en application de l'application des tests|| || || || || || | || || || || ||4 || 4 |

|- | |- | ||

| − | | | + | |Rédaction du rapport || || || || || || | || || || || ||4|| 4 |

|- | |- | ||

| − | | | + | |Rédaction du Wiki|| 1 ||1 ||1 || 1|| 1|| 1|| 1|| 1|| 1||1 ||1 || 11 |

|- | |- | ||

| − | | | + | |'''Total'''|| 13 ||9 ||7 ||6 ||5 || 9||12 ||5 ||10 || 11|| 13|| 100 |

|} | |} | ||

| Ligne 222 : | Ligne 240 : | ||

==Semaine 2== | ==Semaine 2== | ||

| − | Durant cette semaine, il m'a été recommandé de réaliser des TP dédiés aux GIS sur la virtualisation et me familiariser avec les commandes permettant de créer des conteneurs à la main, ce que j'ai réussi à faire | + | Durant cette semaine, il m'a été recommandé de réaliser des TP dédiés aux GIS sur la virtualisation et me familiariser avec les commandes permettant de créer des conteneurs à la main, ce que j'ai réussi à faire. Une fois arrivée à la partie où il faut limiter / restreindre les cpu, la mémoire, le nombre d'entrées/sorties ou encore l'interdiction d'accès à des périphériques, les commandes fonctionnaient mais il fallait tester si elles fonctionnaient bien et qu'elles délimitaient bien. Il a fallu trouver des idées pour tester la mémoire par exemple : allouer de la mémoire en boucle infinie et renvoyer le nombre de fois où ça a été fait afin de vérifier que ça respecte bien la taille donnée dans le cgroup. Cela ne fonctionnait point, et la compréhension des cgroups m'a prise plus de temps que prévu , ce qui m'a retardé... |

==Semaine 3== | ==Semaine 3== | ||

| − | Suite au blocage de la semaine d’avant, je n’ai pas réussi à avancer, j’ai dû réaliser quelques essais mais en vain, j’ai essayé de limiter le nombre de CPUs à utiliser par le conteneur , l’écriture sur le fichier cpuset.cpus en mentionnant le PID du processus du conteneur dans le fichier tasks du pseudo fichier model1 se faisait correctement. Le problème était la vérification, en essayant de lancer des processus différents qui obligeraient l'utilisation d’un autre CPU, le conteneur prenait d’autre CPUs même si | + | Suite au blocage de la semaine d’avant, je n’ai pas réussi à avancer, j’ai dû réaliser quelques essais mais en vain, j’ai essayé de limiter le nombre de CPUs à utiliser par le conteneur , l’écriture sur le fichier cpuset.cpus en mentionnant le PID du processus du conteneur dans le fichier tasks du pseudo fichier model1 se faisait correctement. Le problème était la vérification, en essayant de lancer des processus différents qui obligeraient l'utilisation d’un autre CPU, le conteneur prenait d’autre CPUs même si j’avais fait en sorte qu’il en ait pas le droit. |

| − | De même j’ai essayé de limiter les entrées sorties mais en vain. Seule la restriction mémoire a fonctionné, description des détails dans la section “création des conteneurs à la main” ci dessous. | + | De même, j’ai essayé de limiter les entrées sorties mais en vain. Seule la restriction mémoire a fonctionné, description des détails dans la section “création des conteneurs à la main” ci-dessous. |

| − | J’ai | + | J’ai fini par abandonner les restrictions par les cgroups (et faire ça en parallèle) et entamer d’autres tâches qui me paraissaient prioritaires et ce, en attendant l’aide de mon encadrant. |

==Semaine 4== | ==Semaine 4== | ||

| − | Lors de cette semaine, j'ai installé Docker, | + | Lors de cette semaine, j'ai installé Docker, suivi le Get started pour manier les commandes, découvert son fonctionnement pour finalement mieux comprendre ce qui est demandé de faire dans le projet. J'ai lu de nombreux passages du livre Docker Deep Dive [https://leanpub.com/dockerdeepdive] de Nigel Poulton qui est une référence dans le monde de Docker. C'est un livre qui décrit l'histoire de Docker à travers le temps mais aussi qui rentre dans le détail technique de ses fonctionnalités. Ce document m'a été bénéfique afin de comprendre les tenants et aboutissants de Docker. Cela m'a aidé à imaginer comment mon script allait fonctionner. |

Ainsi, pour mon script, je vais m’inspirer de la syntaxe de docker afin de créer des conteneurs, d'exécuter une commande à l’intérieur de ceux-ci, de créer des bridges réseaux pour les conteneurs, etc. | Ainsi, pour mon script, je vais m’inspirer de la syntaxe de docker afin de créer des conteneurs, d'exécuter une commande à l’intérieur de ceux-ci, de créer des bridges réseaux pour les conteneurs, etc. | ||

| Ligne 236 : | Ligne 254 : | ||

Durant cette semaine, j’ai commencé à réfléchir au cahier des charges précis et clair du projet et j’ai écrit une première ébauche de ce que devra être le format de stockage des fichiers, pour les conteneurs, pour les images et pour les bridges réseau. | Durant cette semaine, j’ai commencé à réfléchir au cahier des charges précis et clair du projet et j’ai écrit une première ébauche de ce que devra être le format de stockage des fichiers, pour les conteneurs, pour les images et pour les bridges réseau. | ||

| − | J’ai donc établi l’architecture logicielle de mon application | + | J’ai donc établi l’architecture logicielle de mon application. Les informations sur les conteneurs, les images et les interfaces réseaux se trouveront dans des fichiers au format CSV qui seront manipulés par mon application. |

En parallèle, il m’a fallu comprendre comment fonctionnaient les veth linux qui permettent de connecter deux espaces de nom réseau différents, et comment les utiliser dans le cadre de mon projet. Il faudra donc faire en sorte de créer une paire de veth par conteneur au moins, et l’une des extrémités de la paire veth sera à mettre dans l’espace de nom du conteneur. L’autre extrémité sera à connecter au bridge Linux côté hôte. | En parallèle, il m’a fallu comprendre comment fonctionnaient les veth linux qui permettent de connecter deux espaces de nom réseau différents, et comment les utiliser dans le cadre de mon projet. Il faudra donc faire en sorte de créer une paire de veth par conteneur au moins, et l’une des extrémités de la paire veth sera à mettre dans l’espace de nom du conteneur. L’autre extrémité sera à connecter au bridge Linux côté hôte. | ||

| − | A la fin de cette séance j’ai réussi à mettre en place plusieurs conteneurs qui communiquent grâce à leurs interfaces virtuelles via un bridge mis dans l’espace de nom hôte, puis j’ai commencé à réfléchir à la façon d’écrire mon script qui fera cela de façon automatique | + | A la fin de cette séance j’ai réussi à mettre en place plusieurs conteneurs qui communiquent grâce à leurs interfaces virtuelles via un bridge mis dans l’espace de nom hôte, puis j’ai commencé à réfléchir à la façon d’écrire mon script qui fera cela de façon automatique. J’ai tenté d’envisager les éventuelles problématiques que je rencontrerai. |

Par exemple, une de mes difficultés est la suivante : lorsque je lance le unshare, il faut faire attention à ce que je garde la main sur le terminal qui lance le unshare, car c’est sur ce terminal que tournera le script. Ainsi, après avoir recherché sur le net, j’ai appris l'existence de l’utilitaire “screen” qui est un multiplexeur de terminal. | Par exemple, une de mes difficultés est la suivante : lorsque je lance le unshare, il faut faire attention à ce que je garde la main sur le terminal qui lance le unshare, car c’est sur ce terminal que tournera le script. Ainsi, après avoir recherché sur le net, j’ai appris l'existence de l’utilitaire “screen” qui est un multiplexeur de terminal. | ||

==Semaine 6== | ==Semaine 6== | ||

| − | Lors de cette semaine j'ai essayé de résoudre le problème du "disown" (pour permettre à mon unshare de continuer à tourner lorsque le shell qui le lance s'arrête) mais en vain | + | Lors de cette semaine j'ai essayé de résoudre le problème du "disown" (pour permettre à mon unshare de continuer à tourner lorsque le shell qui le lance s'arrête) mais en vain. À la fin de chaque exécution, le unshare n’apparaît plus dans la liste des processus. Je me suis aussi documentée sur comment Docker parvenait à franchir cette étape grâce au runc afin de m'en inspirer. |

J'ai préféré donc me mettre à écrire le script me permettant de créer l'interface réseau ainsi que sa configuration lors du lancement du conteneur. Je me suis rendue compte que j'avais mal considéré la structure et le squelette de mes scripts en ne prenant pas en compte les formats d'images de lancement des conteneurs ! Une documentation technique s'est imposée. | J'ai préféré donc me mettre à écrire le script me permettant de créer l'interface réseau ainsi que sa configuration lors du lancement du conteneur. Je me suis rendue compte que j'avais mal considéré la structure et le squelette de mes scripts en ne prenant pas en compte les formats d'images de lancement des conteneurs ! Une documentation technique s'est imposée. | ||

==Semaine 7== | ==Semaine 7== | ||

| − | Durant cette semaine j’ai été boostée et bien avancée car pleins de problèmes | + | Durant cette semaine, j’ai été boostée et j'ai bien avancée car pleins de problèmes se sont débloqués ce qui m’a énormément motivée ! |

| − | En effet, le | + | En effet, le souci des cgroup (mémoire) a été réglé, il était difficile de comprendre pourquoi ça ne fonctionnait pas alors que la méthode décrite sur tous les forums avait l’air simple et fonctionnelle. Il se trouve qu’en limitant la mémoire grâce à “memory.limit_in_bytes” et sans changer memory.swappiness, en arrivant à la limite fixée, le SWAP (défini en annexe) rentrait en action et procurait de l’espace à notre mémoire. Ainsi, nous n’avions pas une limite mémoire fonctionnelle. La solution est de le fixer à 0. |

| + | Ainsi, notre mémoire était complètement limitée ! | ||

L’idée maintenant est de découvrir l’utilité de tous les pseudo fichiers des cgroups concernant les CPU et parvenir à limiter de la même manière les CPU. | L’idée maintenant est de découvrir l’utilité de tous les pseudo fichiers des cgroups concernant les CPU et parvenir à limiter de la même manière les CPU. | ||

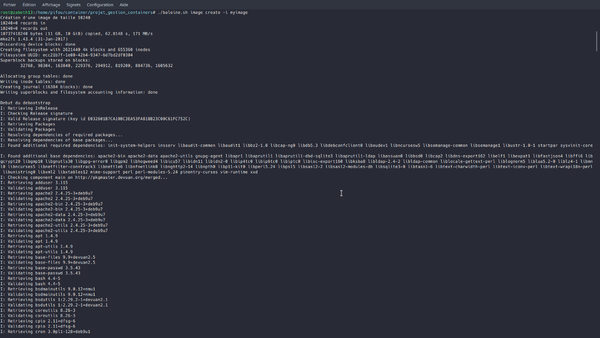

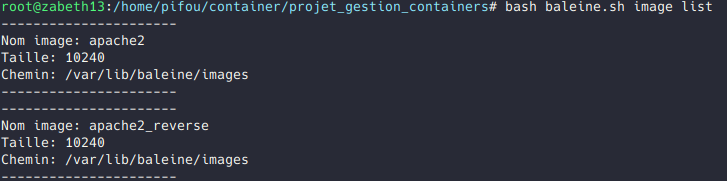

Suite au travail de la semaine précédente, une bonne partie de l’état de l’art sur les images a été écrite, ce qui m’a permis d’avoir une compréhension plus détaillée et précise à ce sujet. Il en a résulté d’une bonne avancée côté script. En effet, on peut désormais en lançant le script créer une image, en choisissant sa taille, stocker son nom, sa taille et son chemin dans un fichier texte portant son nom. | Suite au travail de la semaine précédente, une bonne partie de l’état de l’art sur les images a été écrite, ce qui m’a permis d’avoir une compréhension plus détaillée et précise à ce sujet. Il en a résulté d’une bonne avancée côté script. En effet, on peut désormais en lançant le script créer une image, en choisissant sa taille, stocker son nom, sa taille et son chemin dans un fichier texte portant son nom. | ||

| − | Il faudra entreprendre le script permettant de lister les images. Pour ce dernier, il faudra faire une sorte de manifeste de chaque image, qui décrira cette dernière. A chaque création d’une image, il conviendra d’alimenter ce manifeste. Un format de manifeste d’image est déjà décrit par l’Open Container Initiative (norme que suit Docker). Cette spécification est disponible à l’adresse : [https://github.com/opencontainers/image-spec/blob/master/spec.md] | + | Il faudra entreprendre le script permettant de lister les images. Pour ce dernier, il faudra faire une sorte de manifeste (défini en annexe) de chaque image, qui décrira cette dernière. A chaque création d’une image, il conviendra d’alimenter ce manifeste. Un format de manifeste d’image est déjà décrit par l’Open Container Initiative (norme que suit Docker). Cette spécification est disponible à l’adresse : [https://github.com/opencontainers/image-spec/blob/master/spec.md] |

==Semaine 8== | ==Semaine 8== | ||

| + | |||

| + | Durant cette semaine là, je me suis occupée principalement de l’organisation des manifestes. Le souci c’est que je ne parvenais pas à créer plusieurs images portant le même nom. J’ai essayé donc d’attribuer à chaque image une petite extension contenant un chiffre aléatoire ce qui la distinguerait d’une autre image portant le même nom. Mais cela rendrait plus difficile la manipulation de son manifeste et la récupération de ses informations. | ||

==Semaine 9== | ==Semaine 9== | ||

| + | Pendant cette semaine, je me suis concentrée sur la configuration réseau du conteneur mais j’ai rencontré un certain nombre de soucis. En effet, je ne parvenais pas à exécuter une commande dans le namespace du conteneur. J’utilisais la commande ip netns exec, cependant cette commande attend un nom de namespace et non un identifiant de namespace. Autrement dit je ne pouvais pas utiliser ip netns exec avec l’argument /proc/PID/ns/net, il me fallait en amont créer un nouveau namespace. | ||

==Semaine 10== | ==Semaine 10== | ||

| + | |||

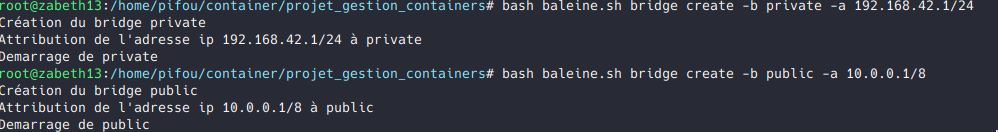

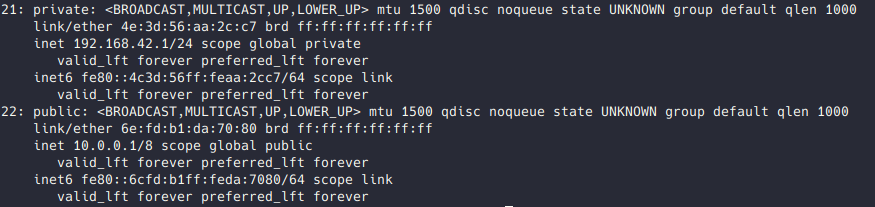

| + | Étant donné qu’il m’a été interdit de lancer un démon ou de perturber le réseau de l'hôte avec des règles de filtrage de paquets, j’utilise de simples bridges linux. | ||

| + | En cette dernière séance officielle de projet, j’ai réussi à : | ||

| + | *créer un bridge depuis le script et créer son manifeste | ||

| + | *le supprimer | ||

| + | *lister les bridges présents | ||

| + | *Mettre up/down un bridge | ||

| + | *lister et supprimer les images | ||

| + | |||

| + | Mais il reste des choses à faire : | ||

| + | |||

| + | *Faire en sorte qu’en une seule commande on arrive à créer une image, créer à partir de la copie de cette dernière le conteneur. | ||

| + | *créer la ferme web pour le test avec mandataire inverse | ||

| + | *Utiliser "cron" pour contrôler les instances | ||

| + | *Importer / exporter une image depuis/vers Docker | ||

| + | *Écrire un Help | ||

| + | |||

| + | == Semaines vacances + semaines supplémentaires == | ||

| + | |||

| + | |||

| + | Il était évident qu’il fallait rajouter des heures supplémentaires pour mener à bien ce projet, je n’ai pas compté les heures ni le temps consacré à réaliser ce projet. | ||

| + | |||

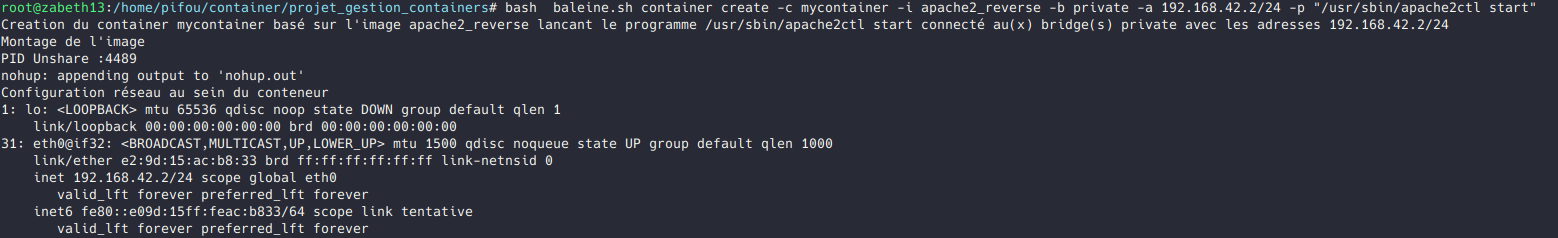

| + | Je suis revenue sur le problème de la configuration réseau que j’avais rencontré deux semaines plus tôt. J’ai découvert que sur Linux, il était impossible d'avoir des interfaces avec des noms de plus de 16 caractères. Et puisque le seul moyen de nommer l’interface de “tel “ conteneur était de reprendre la variable “NOM_CONTAINER” et lui appliquer par exemple la commande : eth0@vif1 | ||

| + | Je me suis donc orientée vers la commande nsenter qui permet de faire ce que je souhaite, c’est à dire d'exécuter une commande à l’intérieur du namespace d’un process. Nsenter me permettra ainsi entre autres d’ajouter une adresse ip à une interface au sein d’un conteneur. | ||

| + | |||

| + | Autre souci auquel je me suis heurtée : le nom des interfaces virtuelles à ajouter au container : le noyau Linux ne permet pas d’avoir des noms d’interface de plus de 16 octets. Ainsi, je ne pouvais pas donner à mes paires veth le nom du conteneur, au risque de faire planter le programme. | ||

| + | |||

| + | J’ai ainsi trouvé une autre solution, de manière à avoir des interfaces réseaux qui soient uniques à un conteneur et qu’on puisse les identifier à l’aide du nom du conteneur. Ma solution consiste à prendre le nom du container, à le hasher en SHA1, puis à prendre les 3 premiers digits significatifs. | ||

| + | |||

| + | Par exemple prenons un container nommé “moncontainer”, le sha1 donne 412c637eebd95f6a5bb63292421b3107b07f076e. Maintenant supposons que l’on souhaite avoir deux interfaces réseau sur ce conteneur. Nous allons récupérer les trois premiers chiffres du hash : 412 puis on rajoute un 4 ème chiffre correspondant à l’indice de l’interface. La première interface du conteneur aura ainsi l’identifiant 4121 et la seconde l’identifiant 4122. | ||

| + | |||

| + | Ainsi, on crée deux vif, la première sera la suivante : vif4121 +--------------> eth0 | ||

| + | , et la seconde sera : vif4121 +----------------> eth1. | ||

| + | |||

| + | [https://stackoverflow.com/questions/24932172/what-length-can-a-network-interface-name-have] | ||

| + | |||

| + | De cette manière on s’assure qu’il est peu probable que deux conteneurs tombent sur le même identifiant de vif. | ||

| + | |||

| + | Une fois que la structure globale du projet était fonctionnelle, je me suis penchée sur les détails du cahier des charges : | ||

| + | |||

| + | *Une mise en place d’un programme permettant de stopper simplement le conteneur. | ||

| + | *Un autre script permettant de démarrer un conteneur déjà existant et “stoppé” . | ||

| + | *Un script pour exécuter des programmes directement sur le conteneur. | ||

| + | |||

| + | *Une meilleure gestion des “list-images/conteneurs/bridges” . En effet, j’ai rajouté des options afin de faciliter l’extraction d’informations des manifestes. J’ai rajouté des “:” avant chaque information. Ainsi, des “cut -d ‘:’ ” serait faisable pour extraire et gérer d’une meilleure façon les manifestes. | ||

| + | |||

| + | *Après cela, je voulais vérifier que je pouvais lancer Apache2 sur mon conteneur | ||

| + | |||

| + | *Un nettoyage “clean-up” du code et ajout de commentaires pour que le code soit lisible et compréhensible par n’importe quel lecteur. | ||

=État de l'art= | =État de l'art= | ||

| Ligne 274 : | Ligne 345 : | ||

L'incidence de la virtualisation sur l'informatique moderne est profonde. Elle permet aux entreprises d'améliorer considérablement la rentabilité et la flexibilité des ressources informatiques. | L'incidence de la virtualisation sur l'informatique moderne est profonde. Elle permet aux entreprises d'améliorer considérablement la rentabilité et la flexibilité des ressources informatiques. | ||

| − | Mais la virtualisation a un coût, notamment au niveau de l'hyperviseur et des systèmes d'exploitation invités, qui requièrent chacun de la mémoire et | + | Mais la virtualisation a un coût, notamment au niveau de l'hyperviseur et des systèmes d'exploitation invités, qui requièrent chacun de la mémoire et d’éventuelles licences coûteuses. Il en résulte une augmentation de la taille de chaque machine virtuelle, ce qui limite le nombre de VM qu'un serveur peut héberger. L'objectif de la conteneurisation vise à virtualiser les applications sans trop alourdir le système. |

| − | L'idée n'est pas nouvelle : depuis plusieurs années déjà, des systèmes d'exploitation tels que OpenVZ, FreeBSD, Solaris Containers et Linux-VServer prennent cette fonctionnalité en charge | + | L'idée n'est pas nouvelle : depuis plusieurs années déjà, des systèmes d'exploitation tels que OpenVZ, FreeBSD, Solaris Containers et Linux-VServer prennent cette fonctionnalité en charge. Mais c'est la récente introduction de plateformes ouvertes, telle que Docker, qui a remis sous les feux de la rampe la conteneurisation et son potentiel en matière d'applications distribuées évolutives. |

== Évolution == | == Évolution == | ||

| Ligne 281 : | Ligne 352 : | ||

La plupart des applications tournent sur des serveurs. Dans le passé, nous ne pouvions exécuter qu’une seule application par serveur. Le monde des systèmes ouverts de Windows et Linux n’avait pas les technologies pour exécuter en toute sécurité plusieurs applications sur un même serveur. | La plupart des applications tournent sur des serveurs. Dans le passé, nous ne pouvions exécuter qu’une seule application par serveur. Le monde des systèmes ouverts de Windows et Linux n’avait pas les technologies pour exécuter en toute sécurité plusieurs applications sur un même serveur. | ||

| − | Bien sûr, chaque fois qu’une entreprise avait besoin d’une nouvelle application, le service informatique allait acheter un nouveau serveur. Et la plupart du temps personne ne connaissait les exigences de performance de la nouvelle application! | + | Bien sûr, chaque fois qu’une entreprise avait besoin d’une nouvelle application, le service informatique allait acheter un nouveau serveur. Et la plupart du temps personne ne connaissait parfaitement les exigences de performance de la nouvelle application ! Cela signifie que le service informatique devait deviner souvent à la volée le modèle et la taille des serveurs à acheter. |

| − | Cela signifie que le service informatique devait deviner | + | |

| − | En conséquence, le service informatique a fait la seule chose à faire: acheter de gros serveurs rapides avec beaucoup de résilience. Après tout, la dernière chose que quelqu'un souhaitait, y compris l'entreprise, était des serveurs | + | En conséquence, le service informatique a fait la seule chose à faire: acheter de gros serveurs rapides avec beaucoup de résilience. Après tout, la dernière chose que quelqu'un souhaitait, y compris l'entreprise, était des serveurs surchargés. Les serveurs surchargés peuvent entraîner une perte de clients et de revenus. Alors, l’IT généralement achetait des serveurs plus gros que ce qui était réellement nécessaire. Cela a entraîné un énorme nombre de serveurs fonctionnant entre 5 et 10% de leur capacité potentielle. Un gaspillage tragique du capital et des ressources de l'entreprise! |

'''Hello VMware !''' | '''Hello VMware !''' | ||

Pour tout cela, VMware, Inc. a fait un cadeau au monde: la machine virtuelle (VM). | Pour tout cela, VMware, Inc. a fait un cadeau au monde: la machine virtuelle (VM). | ||

| − | Et presque du jour au lendemain, le monde s'est transformé en un endroit bien meilleur! Nous avons enfin acquis une technologie qui nous permettrait de gérer en toute sécurité plusieurs applications sur un seul serveur. | + | Et presque du jour au lendemain, le monde s'est transformé en un endroit bien meilleur! Nous avons enfin acquis une technologie qui nous permettrait de gérer en toute sécurité plusieurs applications sur un seul serveur tout en étant isolées les unes des autres. |

| + | |||

| + | C'était une révolution, il n’était plus nécessaire de se procurer un tout nouveau | ||

| + | serveur surdimensionné à chaque fois que l'entreprise demandait une nouvelle application. | ||

| − | + | Tout à coup, tout est devenu bien plus dynamique, lancer une machine virtuelle pour tester une application ou la lancer en production est rapide, contrairement à l'achat de nouveaux serveurs. De plus, la supervision et le management de machines virtuelles est aisé, on peut facilement dupliquer, supprimer, relancer une machine virtuelle. Ce nouveau dynamisme au sein de l'informatique a été un réel tournant à 180 ° ! | |

| − | |||

| − | |||

| − | |||

'''VMwarts''' | '''VMwarts''' | ||

Même si les machines virtuelles sont géniales, elles ne sont pas parfaites! | Même si les machines virtuelles sont géniales, elles ne sont pas parfaites! | ||

| − | Le fait que chaque machine virtuelle nécessite son propre système d'exploitation dédié est un défaut majeur. Chaque OS consomme | + | Le fait que chaque machine virtuelle nécessite son propre système d'exploitation dédié est un défaut majeur. Chaque OS consomme du CPU, de la RAM et du stockage qui pourraient autrement être utilisés pour alimenter davantage les applications. Chaque système d'exploitation a besoin de correctifs et de surveillance. Et dans certains cas, |

chaque système d'exploitation nécessite une licence. | chaque système d'exploitation nécessite une licence. | ||

Le modèle de machine virtuelle présente également d'autres défis. Les machines virtuelles sont lentes à démarrer et à la portabilité pas terrible - migrer et déplacer des charges de travail de machine virtuelle entre hyperviseurs et les plates-formes cloud est plus difficile qu'il ne le faut. | Le modèle de machine virtuelle présente également d'autres défis. Les machines virtuelles sont lentes à démarrer et à la portabilité pas terrible - migrer et déplacer des charges de travail de machine virtuelle entre hyperviseurs et les plates-formes cloud est plus difficile qu'il ne le faut. | ||

| Ligne 304 : | Ligne 375 : | ||

'''Bonjour les conteneurs!''' | '''Bonjour les conteneurs!''' | ||

| − | Pendant longtemps, les grands acteurs du Web tels que Google utilisaient des conteneurs | + | Pendant longtemps, les grands acteurs du Web tels que Google utilisaient des conteneurs. C'est une technologie pour remédier à ces faiblesses du modèle de VM. |

Dans le modèle de conteneur, le conteneur est à peu près analogue à la VM. | Dans le modèle de conteneur, le conteneur est à peu près analogue à la VM. | ||

La différence est que chaque conteneur n’a pas besoin d’un système d’exploitation complet. | La différence est que chaque conteneur n’a pas besoin d’un système d’exploitation complet. | ||

| − | En fait, tous les conteneurs d’un même hôte partagent un même système d’exploitation. Cela libère énormément de quantités de ressources système telles que le processeur, la RAM et le stockage. Il réduit également les coûts de licence potentiels et réduit les frais généraux liés aux correctifs de système d’exploitation et autres | + | En fait, tous les conteneurs d’un même hôte partagent un même système d’exploitation. Cela libère énormément de quantités de ressources système telles que le processeur, la RAM et le stockage. Il réduit également les coûts de licence potentiels et réduit les frais généraux liés aux correctifs de système d’exploitation et autres entretiens. |

Les conteneurs sont également rapides à démarrer et ultra-portables. Déplacement de charges de travail de conteneur depuis votre ordinateur portable vers le cloud, puis vers des ordinateurs virtuels. | Les conteneurs sont également rapides à démarrer et ultra-portables. Déplacement de charges de travail de conteneur depuis votre ordinateur portable vers le cloud, puis vers des ordinateurs virtuels. | ||

| Ligne 318 : | Ligne 389 : | ||

[[Fichier:freebsd-logo.jpg|100px|thumb|right|FreeBSD]] | [[Fichier:freebsd-logo.jpg|100px|thumb|right|FreeBSD]] | ||

Près de deux décennies plus tard, en 2000, un petit fournisseur d’hébergement en environnement partagé est arrivé dans l’historique upBSD des conteneurs avec les FreeBSD jails afin de séparer clairement ses services de ceux de ses clients pour des raisons de sécurité et de facilité d’administration. | Près de deux décennies plus tard, en 2000, un petit fournisseur d’hébergement en environnement partagé est arrivé dans l’historique upBSD des conteneurs avec les FreeBSD jails afin de séparer clairement ses services de ceux de ses clients pour des raisons de sécurité et de facilité d’administration. | ||

| − | Les jails FreeBSD permettent aux administrateurs de partitionner un système informatique FreeBSD en plusieurs systèmes indépendants plus petits, appelés jails, avec la possibilité d'attribuer une adresse IP à chaque système et configuration. | + | Les jails FreeBSD permettent aux administrateurs de partitionner un système informatique FreeBSD en plusieurs systèmes indépendants plus petits, appelés jails, avec la possibilité d'attribuer une adresse IP à chaque système et une configuration. |

'''2001: Linux VServer''' | '''2001: Linux VServer''' | ||

[[Fichier:vserver_linux.png|100px|thumb|right|Linux VServer]] | [[Fichier:vserver_linux.png|100px|thumb|right|Linux VServer]] | ||

| − | Comme les jails FreeBSD, Linux VServer est un mécanisme jail qui permet de partitionner les ressources | + | Comme les jails FreeBSD, Linux VServer est un mécanisme jail qui permet de partitionner les ressources des conteneurs (systèmes de fichiers, adresses réseau, mémoire) sur un système informatique. Introduite en 2001, cette virtualisation de système d’exploitation est mise en œuvre en appliquant un correctif au noyau Linux. Des correctifs expérimentaux sont toujours disponibles, mais le dernier correctif stable a été publié en 2006. |

'''2004: conteneurs Solaris''' | '''2004: conteneurs Solaris''' | ||

| Ligne 330 : | Ligne 401 : | ||

'''2005: Open VZ (Open Virtuzzo)''' | '''2005: Open VZ (Open Virtuzzo)''' | ||

[[Fichier:OpenVZ-logo.png|200px|thumb|right|Open Virtuzzo]] | [[Fichier:OpenVZ-logo.png|200px|thumb|right|Open Virtuzzo]] | ||

| − | Il s'agit d'une technologie de virtualisation au niveau du système d'exploitation pour l'historique de | + | Il s'agit d'une technologie de virtualisation au niveau du système d'exploitation pour l'historique de conteneurs de Linux openVZ, qui utilise un noyau Linux corrigé pour la virtualisation, l'isolation, la gestion des ressources et les points de contrôle. Le code n'a pas été publié dans le noyau officiel de Linux. |

'''2006: conteneurs de processus''' | '''2006: conteneurs de processus''' | ||

| Ligne 339 : | Ligne 410 : | ||

[[Fichier:lxc.png|200px|thumb|right|Lxc]] | [[Fichier:lxc.png|200px|thumb|right|Lxc]] | ||

| − | + | LXC (LinuX Containers) a été la première et la plus complète implémentation du gestionnaire de conteneurs Linux. Il a été implémenté en 2008 à l'aide des “namespace ” cgroups de Linux et fonctionne sur un seul noyau Linux sans nécessiter de correctifs. | |

| − | |||

| − | LXC (LinuX Containers) a été la première et la plus complète implémentation du gestionnaire de conteneurs Linux. Il a été implémenté en 2008 à l'aide des “namespace ” cgroups | ||

Le noyau de Linux 2.6.24 intègre une prise en charge fondamentale de la conteneurisation pour assurer une virtualisation au niveau du système d'exploitation et permettre à un même hôte d'exécuter plusieurs instances Linux isolées, baptisées « conteneurs Linux », ou LXC (LinuX Containers). | Le noyau de Linux 2.6.24 intègre une prise en charge fondamentale de la conteneurisation pour assurer une virtualisation au niveau du système d'exploitation et permettre à un même hôte d'exécuter plusieurs instances Linux isolées, baptisées « conteneurs Linux », ou LXC (LinuX Containers). | ||

LXC repose sur la notion de groupes de contrôle Linux, les cgroups. Ici, chaque groupe de contrôle offre aux applications une isolation totale des ressources (notamment processeur, mémoire et accès E/S), et ce sans recourir à des machines virtuelles à part entière. | LXC repose sur la notion de groupes de contrôle Linux, les cgroups. Ici, chaque groupe de contrôle offre aux applications une isolation totale des ressources (notamment processeur, mémoire et accès E/S), et ce sans recourir à des machines virtuelles à part entière. | ||

| − | Les conteneurs Linux proposent également une isolation complète de | + | Les conteneurs Linux proposent également une isolation complète de leurs espaces de noms. Les fonctions telles que les systèmes de fichiers, les ID réseau et les ID utilisateur, ainsi que tout autre élément généralement associé aux systèmes d'exploitation, peuvent donc être considérés comme « uniques » du point de vue de chaque conteneur. |

'''2011: Warden''' | '''2011: Warden''' | ||

CloudFoundry a commencé Warden en 2011, en utilisant LXC dans le | CloudFoundry a commencé Warden en 2011, en utilisant LXC dans le | ||

| − | début et plus tard en le remplaçant par | + | début et plus tard en le remplaçant par owncloud. Warden peut isoler des environnements sur n’importe quel système d’exploitation, s’exécutant en tant que démon et fournissant une API pour la gestion des conteneurs. Il a développé un modèle client-serveur pour gérer une collection de conteneurs sur plusieurs hôtes, et Warden inclut un service permettant de gérer les groupes de contrôle, les name space et le cycle de vie des processus. |

'''2013: LMCTFY''' | '''2013: LMCTFY''' | ||

| Ligne 359 : | Ligne 428 : | ||

[[Fichier:docker_logo.jpg|200px|thumb|right|Docker]] | [[Fichier:docker_logo.jpg|200px|thumb|right|Docker]] | ||

| − | Lorsque Docker est apparu en 2013, la popularité des conteneurs a explosé. Ce n’est pas une coïncidence: l’histoire croissante des conteneurs de docker a toujours été liée à l’utilisation de | + | Lorsque Docker est apparu en 2013, la popularité des conteneurs a explosé. Ce n’est pas une coïncidence: l’histoire croissante des conteneurs de docker a toujours été liée à l’utilisation de docker et des conteneurs. |

| + | |||

| + | Docker a explosé sur scène en 2013, et cela a causé de l'excitation dans les cercles informatiques. La technologie de conteneur d'application fournie par Docker promet de changer la façon dont les opérations informatiques sont réalisées de la même manière que la technologie de virtualisation quelques années auparavant. | ||

| − | Docker a | + | Autres exemples, Docker propose des outils de génération automatisée de build. Ces outils aident les développeurs à passer plus facilement d'un code source à des applications conteneurisées, ou à travailler avec des outils de "configuration as a code", tels que Chef, Ansible, Puppet et autres, afin d'automatiser ou de rationaliser le processus de build. |

| − | |||

La gestion des versions permet aux développeurs de suivre l'évolution des versions des conteneurs, de comprendre les différences, voire de revenir à des versions antérieures le cas échéant. Et sachant que tout conteneur peut servir d'image de base à un autre, il est d'autant plus facile de réutiliser des composants aisément partageables via un registre public (ou privé). | La gestion des versions permet aux développeurs de suivre l'évolution des versions des conteneurs, de comprendre les différences, voire de revenir à des versions antérieures le cas échéant. Et sachant que tout conteneur peut servir d'image de base à un autre, il est d'autant plus facile de réutiliser des composants aisément partageables via un registre public (ou privé). | ||

| − | Tout comme Warden, Docker a également utilisé LXC à ses débuts et a par la suite remplacé ce gestionnaire de conteneurs par sa propre bibliothèque, libcontainer. Mais il ne fait aucun doute que Docker s’est séparé du pack en offrant un écosystème complet pour la gestion des conteneurs. | + | Tout comme Warden, Docker a également utilisé LXC à ses débuts et a par la suite remplacé ce gestionnaire de conteneurs par sa propre bibliothèque, libcontainer (plus tard apellée containerD). Mais il ne fait aucun doute que Docker s’est séparé du pack en offrant un écosystème complet pour la gestion des conteneurs. |

| − | |||

| − | |||

| − | |||

| − | |||

'''2017: Les outils de conteneur deviennent matures''' | '''2017: Les outils de conteneur deviennent matures''' | ||

| Ligne 397 : | Ligne 463 : | ||

En conséquence, Docker. Inc. a développé son propre outil appelé libcontainer en tant que | En conséquence, Docker. Inc. a développé son propre outil appelé libcontainer en tant que | ||

| − | remplacement pour LXC. Le but de libcontainer était d'être une plate-forme agnostique outil permettant à Docker d’avoir accès | + | remplacement pour LXC. Le but de libcontainer était d'être une plate-forme agnostique outil permettant à Docker d’avoir accès à la plate-forme de base des conteneurs -blocs qui existent dans le système d'exploitation. |

Libcontainer a remplacé LXC en tant que pilote d'exécution par défaut dans Docker 0.9. | Libcontainer a remplacé LXC en tant que pilote d'exécution par défaut dans Docker 0.9. | ||

| Ligne 403 : | Ligne 469 : | ||

| − | Aujourd’hui, Dave Bartoletti, analyste chez Forrester, pense que seulement 10% des entreprises utilisent actuellement des conteneurs en production, mais près d’un tiers sont en phase de test. Docker a généré 762 millions de dollars de revenus en 2016. Les conteneurs ont | + | Aujourd’hui, Dave Bartoletti, analyste chez Forrester, pense que seulement 10% des entreprises utilisent actuellement des conteneurs en production, mais près d’un tiers sont en phase de test. Docker a généré 762 millions de dollars de revenus en 2016. Les conteneurs ont transformé le monde de l’informatique car ils utilisent des systèmes d’exploitation partagés. Cette technologie permet à un data center ou à un fournisseur Cloud d’économiser des dizaines de millions de dollars par an, mais tout dépend bien sûr des risques qu’il serait prêt à prendre. |

Cependant, quelques préoccupations existent concernant l’assurance qu’auront les développeurs d’innover librement en utilisant des conteneurs. Les développeurs devraient pouvoir choisir les outils et les frameworks qu’ils souhaitent utiliser sans avoir à demander systématiquement la permission. L’utilisation d’un conteneur pourrait en effet étouffer la créativité d’un développeur… | Cependant, quelques préoccupations existent concernant l’assurance qu’auront les développeurs d’innover librement en utilisant des conteneurs. Les développeurs devraient pouvoir choisir les outils et les frameworks qu’ils souhaitent utiliser sans avoir à demander systématiquement la permission. L’utilisation d’un conteneur pourrait en effet étouffer la créativité d’un développeur… | ||

Le choix incombe, alors à l’entreprise d'investir ou non dans les conteneurs. Avec les avantages et les inconvénients qui se contrebalancent, tout peut se résumer au goût du risque. | Le choix incombe, alors à l’entreprise d'investir ou non dans les conteneurs. Avec les avantages et les inconvénients qui se contrebalancent, tout peut se résumer au goût du risque. | ||

| Ligne 410 : | Ligne 476 : | ||

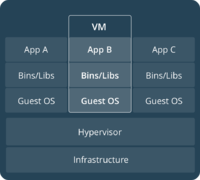

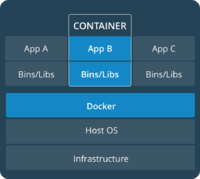

[[Fichier:machinevirtuelle.png|200px|thumb|right|VM]] | [[Fichier:machinevirtuelle.png|200px|thumb|right|VM]] | ||

[[Fichier:conteneur.png|200px|thumb|left|Conteneur]] | [[Fichier:conteneur.png|200px|thumb|left|Conteneur]] | ||

| − | Bien | + | Bien sûr, la conteneurisation a de nombreux avantages par rapport à la virtualisation mais on ne peut pas affirmer que cette technologie est 100% parfaite, elle a aussi son lot d’inconvénients. |

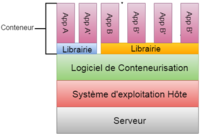

Ces deux schémas ci dessus, d’un environnement de virtualisation et d’un environnement de conteneurisation permettent de bien identifier les différences entre ces deux technologies. | Ces deux schémas ci dessus, d’un environnement de virtualisation et d’un environnement de conteneurisation permettent de bien identifier les différences entre ces deux technologies. | ||

| − | Tout d’abord, les conteneurs partagent un seul et unique système d’exploitation, de ce fait, l’échange de données entre les conteneurs est plus simple et plus rapides que pour les VM. De plus comme chaque conteneur de contient pas de système d’exploitation propre à lui, les conteneurs sont donc réduits et prennent moins de place et moins de ressource Serveur (environ 10 fois plus petit qu’un VM). Le temps de création et de suppression d’un conteneur est par la même occasion réduit. | + | Tout d’abord, les conteneurs partagent un seul et unique système d’exploitation, de ce fait, l’échange de données entre les conteneurs est plus simple et plus rapides que pour les VM. De plus comme chaque conteneur de ne contient pas de système d’exploitation propre à lui, les conteneurs sont donc réduits et prennent moins de place et moins de ressource Serveur (environ 10 fois plus petit qu’un VM). Le temps de création et de suppression d’un conteneur est par la même occasion réduit. |

| − | Les conteneurs facilitent l’évolution technique, par exemple si dans un environnement de VM, l’on souhaite faire évoluer les OS de plusieurs VM, il faut le faire manuellement sur chaque Machines. Ce problème n’est pas présent pour la conteneurisation car toute l’infrastructure repose sur un seul | + | Les conteneurs facilitent l’évolution technique, par exemple si dans un environnement de VM, l’on souhaite faire évoluer les OS de plusieurs VM, il faut le faire manuellement sur chaque Machines. Ce problème n’est pas présent pour la conteneurisation car toute l’infrastructure repose sur un seul système d’exploitation. |

Mais la conteneurisation peut avoir quelques inconvénients, comme tous les conteneurs ne reposent que sur un seul système d’exploitation, la diversification des systèmes d’exploitation n’est pas possible avec la conteneurisation, « ou est plus compliquée à mettre en place ». Les conteneurs sont isolés pour assurer la sécurité et empêcher les malwares de se transmettre entre les conteneurs, mais il est évident que les machines virtuelles seront toujours plus isolées que les conteneurs. Même si les conteneurs ont un grand nombre d’avantages, leur apparition ne sonne pas la fin de la virtualisation. Aujourd’hui, les machines virtuelles sont intégrées dans de nombreuses entreprises comportant des réseaux de grande taille. Pour utiliser entièrement la technologie de conteneurisation, ces entreprises devraient remanier tout leur système informatique ce qui est impensable. Mais de nouvelles entreprises ont vu le potentiel de la conteneurisation et on donc créer leur système informatique en fonction. | Mais la conteneurisation peut avoir quelques inconvénients, comme tous les conteneurs ne reposent que sur un seul système d’exploitation, la diversification des systèmes d’exploitation n’est pas possible avec la conteneurisation, « ou est plus compliquée à mettre en place ». Les conteneurs sont isolés pour assurer la sécurité et empêcher les malwares de se transmettre entre les conteneurs, mais il est évident que les machines virtuelles seront toujours plus isolées que les conteneurs. Même si les conteneurs ont un grand nombre d’avantages, leur apparition ne sonne pas la fin de la virtualisation. Aujourd’hui, les machines virtuelles sont intégrées dans de nombreuses entreprises comportant des réseaux de grande taille. Pour utiliser entièrement la technologie de conteneurisation, ces entreprises devraient remanier tout leur système informatique ce qui est impensable. Mais de nouvelles entreprises ont vu le potentiel de la conteneurisation et on donc créer leur système informatique en fonction. | ||

| + | == Les images == | ||

| + | [[Fichier:images_docker.png]] | ||

| − | |||

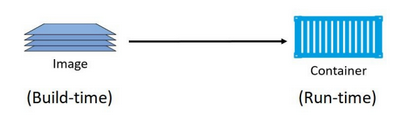

La figure présente une vue de haut niveau de la relation entre les images et | La figure présente une vue de haut niveau de la relation entre les images et | ||

| − | conteneurs. Nous utilisons les commandes : docker container run et docker service create pour démarrer un ou plusieurs conteneurs à partir d'une seule image. | + | conteneurs. Nous utilisons les commandes : "docker container run" et "docker service create" pour démarrer un ou plusieurs conteneurs à partir d'une seule image. |

Cependant, une fois qu’on a démarré un conteneur à partir d'une image, les deux constructions deviennent dépendantes les unes des autres et on ne peut pas supprimer l'image avant que le dernier conteneur l'utilisant ait été arrêté et détruit. Tenter de supprimer une image sans s'arrêter et la destruction de tous les conteneurs l’utilisant entraînera l’erreur suivante : | Cependant, une fois qu’on a démarré un conteneur à partir d'une image, les deux constructions deviennent dépendantes les unes des autres et on ne peut pas supprimer l'image avant que le dernier conteneur l'utilisant ait été arrêté et détruit. Tenter de supprimer une image sans s'arrêter et la destruction de tous les conteneurs l’utilisant entraînera l’erreur suivante : | ||

| Ligne 435 : | Ligne 502 : | ||

Cependant, les conteneurs sont connus pour être rapide et léger. Cela veut dire que les images à partir desquelles ils sont construits sont généralement petites et dépouillées de toutes les parties non essentielles. | Cependant, les conteneurs sont connus pour être rapide et léger. Cela veut dire que les images à partir desquelles ils sont construits sont généralement petites et dépouillées de toutes les parties non essentielles. | ||

Par exemple, les images Docker ne sont pas livrées avec 6 shells différents. | Par exemple, les images Docker ne sont pas livrées avec 6 shells différents. | ||

| − | + | Elles sont généralement livrées avec un seul shell minimaliste, ou aucun shell du tout. Elles ne contiennent pas non plus de kernel - tous les conteneurs s'exécutant sur le Docker hôte partagent un accès à au kernel de l’hôte du kernel. Pour ces raisons, on dit parfois que les images ne contiennent pas suffisamment de système d'exploitation (généralement elles contiennent que des fichiers et des objets du système de fichiers liés au système d'exploitation). | |

| − | L’image officielle d’Alpine Linux Docker fait environ 4 Mo de taille et représente un | + | L’image officielle d’Alpine Linux Docker fait environ 4 Mo de taille et représente un bon exemple de la petite taille des images Docker. Cependant, un exemple plus typique pourrait être quelque chose comme l’image officielle Ubuntu Docker qui fait actuellement environ 120 Mo. Ceux-ci sont clairement dépouillés de la plupart des parties non essentielles ! |

| − | exemple de la petite taille des images Docker. Cependant, un exemple plus typique pourrait être quelque chose comme | + | Les images Windows ont tendance à être plus volumineuses que les images Linux, à cause de la façon dont le système d'exploitation Windows fonctionne. Par exemple, la dernière version de .NET |

| − | Les images Windows ont tendance à être plus volumineuses que les images Linux, à cause de la façon dont le système d'exploitation Windows fonctionne. Par exemple, la dernière version de | + | image (microsoft / dotnet:latest) est supérieure à 2 Go lorsqu’elle est extrait sans compression. |

| − | image (microsoft / dotnet:latest) est supérieure à 2 Go | ||

L'image de Windows Server 2016 Nano Server dépasse légèrement 1 Go lorsqu'elle est tirée et non compressé. | L'image de Windows Server 2016 Nano Server dépasse légèrement 1 Go lorsqu'elle est tirée et non compressé. | ||

| Ligne 455 : | Ligne 521 : | ||

'''Nom de l'image''' | '''Nom de l'image''' | ||

| − | Dans le cadre de chaque commande, nous devions spécifier quelle image extraire. | + | Dans le cadre de chaque commande, nous devions spécifier quelle image extraire. Pour ce faire, nous avons besoin d’un peu de contexte sur la manière de stocker les images. |

| − | Registres d'images | + | Registres d'images : |

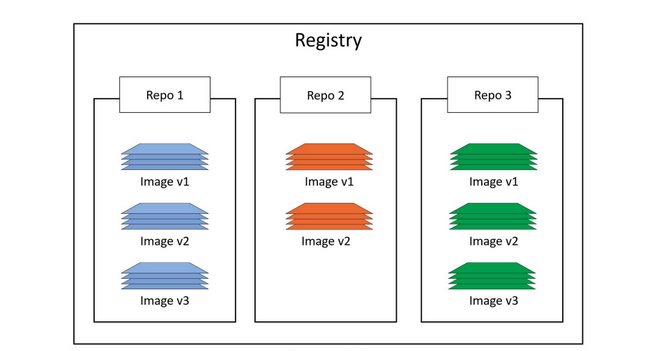

| − | Les images Docker sont stockées dans des registres d'images. Le registre le plus courant est Docker Hub | + | Les images Docker sont stockées en ligne dans des registres d'images. Le registre le plus courant est Docker Hub [https://hub.docker.com]. Il existe d'autres registres, y compris des registres tiers . Cependant, le client Docker est avisé et utilise par défaut Docker Hub. |

| + | |||

| + | Les registres d'images contiennent plusieurs référentiels d'images. À leur tour, les référentiels d’images peuvent contenir plusieurs images. Cela pourrait être un peu déroutant, alors la figure montre une image d'un registre d'images contenant 3 référentiels, et chaque référentiel contient une ou plusieurs images. | ||

| − | Les | + | [[Fichier:registry_docker.png]] |

| + | |||

| + | '''Dépôts officiels et non officiels''' | ||

| + | |||

| + | Docker Hub a également le concept de référentiels officiels et non officiels des dépôts. | ||

| + | |||

| + | Comme le nom l'indique, les référentiels officiels contiennent des images qui ont été vérifiées par Docker, Inc. Cela signifie qu'ils doivent contenir un code à jour et de haute qualité, sécurisé, bien documenté et conforme aux meilleures pratiques. | ||

| + | Les référentiels non officiels sont tout le contraire. | ||

| + | |||

| + | '''Nom et marquage des images''' | ||

| + | |||

| + | Le format pour docker : image pull | ||

| + | quand on travaille avec une image d'un dépôt officiel, c'est: | ||

| + | |||

| + | docker image pull <repository>: <tag> | ||

| + | |||

| + | Dans les exemples Linux précédents, nous avons téléchargé des images Alpine et Ubuntu. | ||

| + | avec les deux commandes suivantes: | ||

| + | |||

| + | docker image pull alpine:latest and docker image pull ubuntu:latest | ||

| + | |||

| + | Les commandes suivantes montrent comment téléchargé différentes images d’un référentiel officiel: | ||

| + | |||

| + | $ docker image pull mongo:3.3.11 | ||

| + | //This will pull the image tagged as `3.3.11` | ||

| + | //from the official `mongo` repository. | ||

| + | $ docker image pull redis:latest | ||

| + | //This will pull the image tagged as `latest` | ||

| + | //from the official `redis` repository. | ||

| + | $ docker image pull alpine | ||

| + | //This will pull the image tagged as `latest` | ||

| + | //from the official `alpine` repository. | ||

| + | |||

| + | Quelques points à noter sur les commandes ci-dessus : | ||

| + | Tout d’abord, si on ne spécifie pas de balise d’image après le nom du référentiel, Docker suppose que nous nous référons à la dernière image. | ||

| + | |||

| + | Deuxièmement, la dernière balise n’a aucun pouvoir magique! Juste parce qu'une image est étiquetée comme dernière ne garantit pas que c’est l’image est la plus récente dans un dépôt! | ||

| + | |||

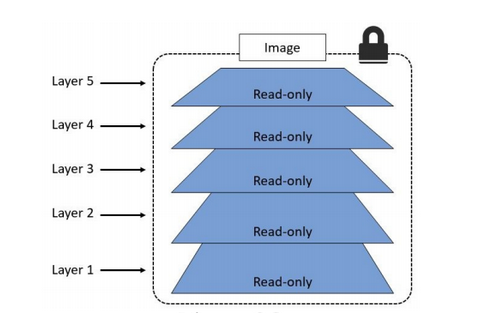

| + | ''' Images et couches ''' | ||

| + | |||

| + | Une image Docker est juste un groupe de couches en lecture seule faiblement connectés. | ||

| + | Docker s’occupe d’empiler ces couches et de les représenter comme un seul objet unifié. | ||

| + | Il y a plusieurs façons de voir et d'inspecter les couches qui composent une image: | ||

| + | |||

| + | |||

| + | [[Fichier:images_layer_docker.png]] | ||

| + | |||

| + | Toutes les images Docker commencent par une couche de base, et au fur et à mesure que des modifications sont apportées, le contenu est ajouté, les nouvelles couches sont ajoutées en haut. | ||

| + | |||

| + | '''Les hachages d'image (digests)''' | ||

| + | |||

| + | |||

| + | L’image n’est en réalité qu’un objet de configuration répertoriant les couches et ainsi que certaines métadonnées (telle que son nom par exemple). | ||

| + | Les couches constituant une image sont totalement indépendantes et n’ont aucune notion de faire partie d'une image collective. | ||

| + | |||

| + | Chaque image est identifiée par un identifiant de cryptage qui est un hachage de l'objet config. Chaque couche est identifiée par un identifiant de cryptage qui est un hachage du contenu qu’elle contient. | ||

| + | |||

| + | Cela signifie que changer le contenu de l'image, ou de l'une de ses couches, | ||

| + | provoquera le changement des cryptages associés. En conséquence, les images et les couches sont immuables. | ||

| + | |||

| + | Lorsqu’on push et pull les images, nous compressons leurs couches pour économiser la bande passante. | ||

| + | Mais la compression d’une couche change son contenu ! Cela signifie que le contenu du hachage ne correspond plus après l'opération de push et pull ! Ceci est évidemment un problème. | ||

| + | Par exemple, lorsqu’on place une couche d’image sur Docker Hub, Docker Hub | ||

| + | tente de vérifier que l'image est arrivée sans être altérée en route. | ||

| + | Pour ce faire, il exécute un hachage sur la couche et vérifie s'il correspond au | ||

| + | hash qui a été envoyé avec la couche. Parce que la couche a été compressée (modifiée) la vérification du hachage échouera. | ||

| + | |||

| + | Pour résoudre ce problème, chaque couche reçoit également un élément appelé hachage de distribution. C’est un hachage de la version compressée de la couche. Quand une couche est push et pull du registre, son hash de distribution est inclus, et c'est ce qui est utilisé pour vérifier que la couche est arrivée sans être altérée. | ||

| + | Ce modèle de stockage à contenu adressable améliore considérablement la sécurité en nous offrant un moyen d’imprimer et de superposer des données après des opérations de push et pull. Cela évite aussi les collisions d'identifiants pouvant survenir si les identifiants d'image et de couche étaient générés de manière aléatoire. | ||

| + | |||

| + | |||

| + | '''Images multi-architecturales''' | ||

| + | |||

| + | Docker prend désormais en charge les images multi-plateformes et multi-architectures. | ||

| + | Cela signifie qu’un référentiel d’images et une balise doivent avoir une image pour Linux sur x64 et Linux sur PowerPC, etc. | ||

| + | Pour ce faire, l’API de registre prend en charge un fat manifest ainsi qu’une image | ||

| + | manifest. Les fat manifests listent les architectures supportées par une image particulière, tandis que l'image manifest, liste les couches qui composent une image particulière. | ||

| + | |||

| + | Supposons qu’on utilise Docker sous Linux x64. Quand on pull une image depuis | ||

| + | Docker hub, notre client Docker adresse les demandes d’API pertinentes à Docker API tournant sur Docker Hub. | ||

| + | Si un fat manifest existe pour cette image, il sera analysé pour voir s’il existe une entrée pour Linux sur x64. Si elle existe, l'image manifest pour cette image est récupérée et analysée pour les couches réelles qui composent l'image. Les couches sont identifiées par leurs identifiants de cryptage et sont extraites du Registre “blob”. | ||

| + | |||

| + | '''Supprimer des images''' | ||

| + | |||

| + | Lorsqu’on n’a plus besoin d'une image, on peut la supprimer de notre hôte Docker | ||

| + | avec la commande : | ||

| + | docker image rm. rm | ||

| + | Supprimer les images “pull” dans les étapes précédentes avec la commande: | ||

| + | docker image rm | ||

| + | |||

| + | Si l'image qu’on essaye de supprimer est utilisée par un conteneur en cours d'exécution, on ne pourra pas la supprimer. Il faudra Arrêter et supprimer tous les conteneurs avant d'essayer la suppression à nouveau. | ||

| + | Un raccourci pratique pour nettoyer un système et supprimer toutes les images sur un Docker hôte est d’exécuter la commande docker image rm et lui transmettre une liste de tous les ID d'image sur le système en appelant l'image de menu fixe ls avec l'indicateur -q. | ||

| + | |||

| + | docker image rm $(docker image ls -q) -f | ||

=Création des conteneurs "à la main" = | =Création des conteneurs "à la main" = | ||

| Ligne 475 : | Ligne 636 : | ||

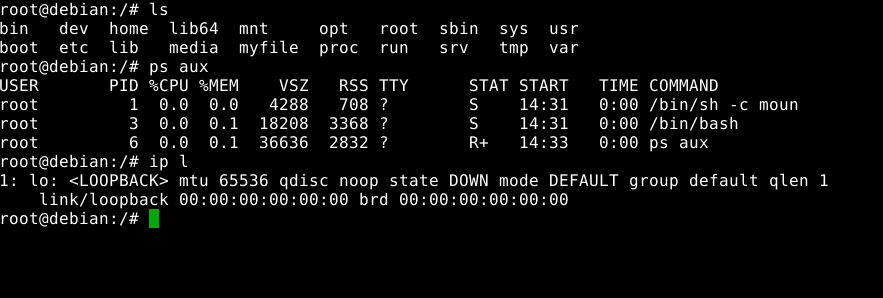

'''Montage du système de fichiers''' | '''Montage du système de fichiers''' | ||

| − | J’ai | + | J’ai créé le répertoire qui contiendra les rootfs montés : |

mount -t ext4 -o loop /home/pifou/hmalti/hmalti /mnt/container_hmalti | mount -t ext4 -o loop /home/pifou/hmalti/hmalti /mnt/container_hmalti | ||

| Ligne 485 : | Ligne 646 : | ||

export http_proxy=http://proxy.polytech-lille.fr:3128 | export http_proxy=http://proxy.polytech-lille.fr:3128 | ||

| − | Ensuite j’utilise l'outil | + | Ensuite j’utilise l'outil debootstrap dans /mnt/container_hmalti pour créer une arborescence Debian de base. |

debootstrap --include=apache2,vim,nano stable /mnt/container_hmalti | debootstrap --include=apache2,vim,nano stable /mnt/container_hmalti | ||

| Ligne 501 : | Ligne 662 : | ||

mount -t ext4 -o loop /home/pifou/hmalti/hmalti /mnt/container_hmalti | mount -t ext4 -o loop /home/pifou/hmalti/hmalti /mnt/container_hmalti | ||

| − | Afin de vérifier que le fichier est bien | + | Afin de vérifier que le fichier est bien créé |

ls /mnt/container_hmalti | ls /mnt/container_hmalti | ||

| Ligne 515 : | Ligne 676 : | ||

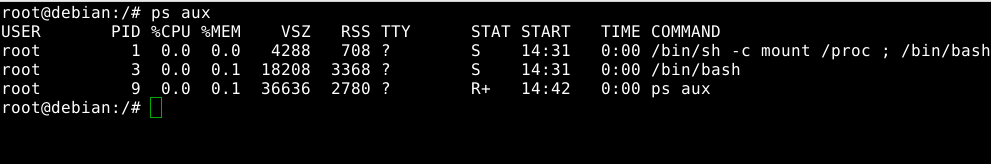

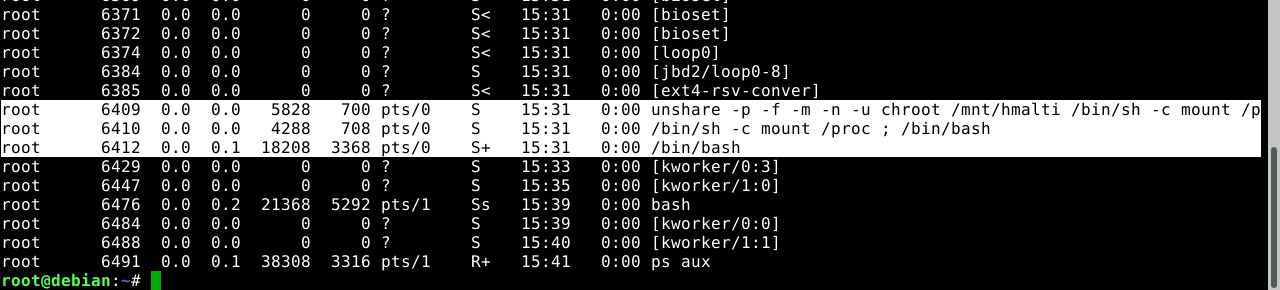

ps aux (on ne trouve que 3 processus, ce qui est logique ) | ps aux (on ne trouve que 3 processus, ce qui est logique ) | ||

| − | De même pour ce qui de l’adresse réseau de notre conteneur : | + | De même pour ce qui est de l’adresse réseau de notre conteneur : |

ip l (Dans le conteneur nous ne voyons pas les interfaces réseau de l'hôte car nous ne sommes pas dans le même espace de nom) | ip l (Dans le conteneur nous ne voyons pas les interfaces réseau de l'hôte car nous ne sommes pas dans le même espace de nom) | ||

| Ligne 536 : | Ligne 697 : | ||

Ce sera donc ce dernier PID que l’on mettra dans “tasks” | Ce sera donc ce dernier PID que l’on mettra dans “tasks” | ||

| − | |||

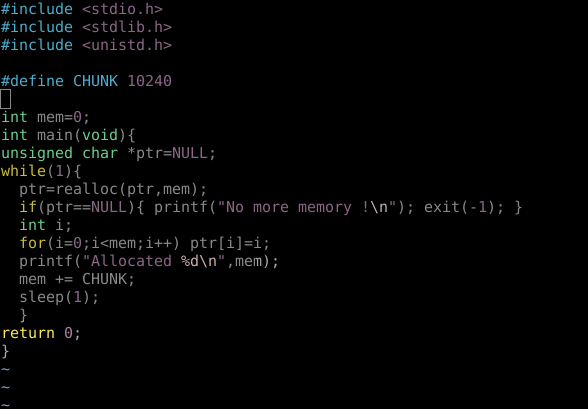

| − | + | '''Restriction sur l’utilisation mémoire :''' | |

| − | |||

| − | |||

| − | ' | + | Le bout de code ci-dessous permet d'allouer 10K de mémoire toutes les secondes en boucle |

mkdir /sys/fs/cgroup/memory/model1 | mkdir /sys/fs/cgroup/memory/model1 | ||

| − | echo | + | echo 2048000 > /sys/fs/cgroup/memory/model1/memory.limit_in_bytes |

| − | echo $pid > /sys/fs/cgroup/memory/ | + | echo 2048000 > /sys/fs/cgroup/memory/model1/memory.memsw.limit_in_bytes |

| + | echo 0 > /sys/fs/cgroup/memory/model1/memory.swappiness | ||