IMA5 2019/2020 P09 : Différence entre versions

(→Semaine 4 : 30 Septembre - 6 Octobre) |

(→Semaine 3 : 23 - 29 Septembre) |

||

| Ligne 615 : | Ligne 615 : | ||

==Semaine 3 : 23 - 29 Septembre == | ==Semaine 3 : 23 - 29 Septembre == | ||

| − | === | + | === Premier pas du robo=== |

Comment roule le robot ? Le robot possède 6 roues reliées à six moteurs à courant continu. | Comment roule le robot ? Le robot possède 6 roues reliées à six moteurs à courant continu. | ||

| Ligne 628 : | Ligne 628 : | ||

| − | === | + | ===Code === |

void setup(){ | void setup(){ | ||

pinMode(pinMoteur,OUTPUT); | pinMode(pinMoteur,OUTPUT); | ||

| Ligne 640 : | Ligne 640 : | ||

| − | === | + | === Orientation du robot === |

Pour permettre le déplacement du robot, il faut actionner les moteurs. Ci-dessous, une photo du robot: | Pour permettre le déplacement du robot, il faut actionner les moteurs. Ci-dessous, une photo du robot: | ||

| Ligne 691 : | Ligne 691 : | ||

J'ai donc une dizaine de fonctions qui me permettent de déplacer le robot. | J'ai donc une dizaine de fonctions qui me permettent de déplacer le robot. | ||

| − | === | + | === Rendez-vous Bonduelle === |

Nous avons décidé de remplacer l'Arduino par un ESP32, un microprocesseur qui possède deux coeurs, ce qui lui permet de gérer simultanément deux tâches à la fois. Nous avons défini les objectifs pour les prochaines semaines et pour la première soutenance. Dans un premier temps, il faudra que je me concentre sur la réception et le traitement des données du LIDAR. | Nous avons décidé de remplacer l'Arduino par un ESP32, un microprocesseur qui possède deux coeurs, ce qui lui permet de gérer simultanément deux tâches à la fois. Nous avons défini les objectifs pour les prochaines semaines et pour la première soutenance. Dans un premier temps, il faudra que je me concentre sur la réception et le traitement des données du LIDAR. | ||

| Ligne 697 : | Ligne 697 : | ||

| − | === | + | === Lidar === |

L'entreprise propose un logiciel avec le LIDAR X4 qui fonctionne uniquement sous Windows. Ce logiciel permet visualiser les résultats du scan réalisé avec le LIDAR, avec une visualisation en 2D/3D des points. | L'entreprise propose un logiciel avec le LIDAR X4 qui fonctionne uniquement sous Windows. Ce logiciel permet visualiser les résultats du scan réalisé avec le LIDAR, avec une visualisation en 2D/3D des points. | ||

Version du 11 novembre 2019 à 20:21

Sommaire

- 1 Présentation générale

- 2 Préparation du projet

- 3 Etat de l'art

- 4 Réalisation du Projet

- 5 Documents Rendus

Présentation générale

Sujet : Véhicule autonome pour cartographie

Etudiant : MEJBAR Lina

Encadrants : Alexandre Boé / Xavier Redon / Thomas Vantroys / Xavier Chenot

Description

Le secteur de l'intelligence artificielle a été beaucoup marqué durant la dernière décennie par une évolution du nombre de recherches et de publications scientifiques. Son but est de concevoir des systèmes capables de reproduire le comportement humain et son raisonnement. S'il est vrai que de domaine parait très abstrait, il possède de nombreux avantages lorsqu'on sait comment l'utiliser. Le retail, l'industrie ou encore la sécurité sont des secteurs qui deviennent de plus en plus performants lorsque l'intelligence artificielle est développée. L'objectif est de permettre une automatisation plus intelligente des tâches. Le machine learning est un champ d'étude de l'intelligence artificielle qui se fonde sur des approches statistiques pour donner aux ordinateurs la capacité d' « apprendre » à partir de données.

Objectifs

La mission sera de proposer un système autonome (véhicule mobile) capable de se déplacer dans une zone et de la cartographier. Le système doit pouvoir ensuite trouver le chemin adéquat pour se déplacer d’un point à un autre tout en évitant des obstacles fixes et/ou mobiles. Ce projet est proposé par l'entreprise Bonduelle. Le but final, serait de placer le robot dans leur entrepôt, et qu'il puisse déplacer une plaquette de produit d'un point A à un point B, tout en évitant les obstacles et en cartographiant la pièce.

Préparation du projet

Cahier des charges

Dans un contexte international de développement de projet innovants, il faudra proposer un système autonome (véhicule mobile) capable de se déplacer dans une zone et de la cartographier. Le système doit pouvoir ensuite trouver le chemin adéquat pour se déplacer d’un point à un autre tout en évitant des obstacles fixes et/ou mobiles.

Choix techniques : matériel et logiciel

Matériel mis à disposition par Polytech :

- VL6180X Distance Sensor

- Carte Raspberry Pi 3GB

Matériels mis à disposition par Bonduelle :

- Robot kit : Yahboom Professional 6WD UNO R3 smart robot kit compatible with Arduino

- Carte Arduino fournie dans le kit

- Carte Raspberry Pi 4GB et carte SD

- Kit pour déplacement caméra suivant deux axes

Questions

Cartographie :

→Quel taille de pièce vise-t-on ?

→ Combien de temps doit prendre la cartographie ?

→ Sous quel format doit être la cartographie ?

Intelligence Artificielle

→ Quelles formes doit reconnaitre le robot ?

Matériel

→ Proposition d'un capteur ultrason

Robot

→Trouver une solution pour le rendre plus robuste

Liste des tâches à effectuer

| Tâche \ Heures | S1 | S2 | S3 | S4 | S5-S6 | S7 | S8-9 | S10 | S11 | S12 | S13 | S14 | S15 | S16 | S17 | S18 | S19 | S20 | S21 | Total |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Analyse | ||||||||||||||||||||

| Analyse du projet | 2 | 2 | 1 | 5 | ||||||||||||||||

| Recherches concernant le projet | 2 | 2 | 2 | 6 | ||||||||||||||||

| Montage du robot | 2 | 2 | ||||||||||||||||||

| Formation | ||||||||||||||||||||

| Formation Machine Learning | 2 | 2 | ||||||||||||||||||

| Formation Partie Cartographie (LIDAR) | 4 | 2 | 3 | 9 | ||||||||||||||||

| Code | ||||||||||||||||||||

| Code Arduino | 3 | 3 | 6 | |||||||||||||||||

| Code C++ : Lidar | 2 | 4 | 6 | |||||||||||||||||

| Code du site Web | 3 | 4 | 4 | 2 | 13 | |||||||||||||||

| Code Python | 4 | 4 | ||||||||||||||||||

| Rencontre Tuteurs | ||||||||||||||||||||

| Rencontre Bonduelle | 1 | 1 | 2 | 2 | 4 | 4 | 2 | 16 | ||||||||||||

| Documentation | ||||||||||||||||||||

| Remplissage du wiki | 2 | 1 | 2 | 3 | 3 | 2 | 2 | 15 | ||||||||||||

| Préparation Soutenance 1 | 2 | 2 | ||||||||||||||||||

| Préparation Soutenance 2 | ||||||||||||||||||||

| Rédaction du rapport (Interm et Final) | ||||||||||||||||||||

| Total | 11 | 6 | 12 | 12 | 20 | 13 | 12 |

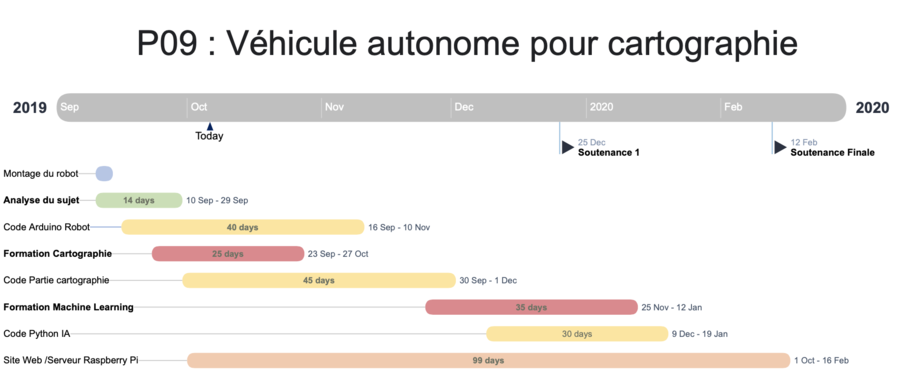

Calendrier prévisionnel

Etat de l'art

- L’aspirateur robot IRobot I7+ est un aspirateur autonome nouvelle génération. Il se vide automatiquement dans un sac fermé pouvant contenir l’équivalent de 30 bacs. Le robot doit bien entendu récupérer la poussière, éviter les obstacles fixes (meubles, murs ..) et mobiles (personnes, animaux ..). Sa particularité est qu'il peut cartographier la maison après deux-trois passages. Ce robot est commercialisé 1200€.

- Un deuxième robot avec les mêmes caractéristiques que mon cahier des charges a vu le jour en 2017. C'est le robot mobile Apollo qui est l’une des meilleures bases mobiles du marché. Il est doté de plusieurs capteurs, un LIDAR, une caméra de profondeur, un capteur ultrason, un capteur de dénivelation et un SLAMWARE. Il a été pensé pour pouvoir évoluer de manière autonome dans des lieux publics et être capable de faire face à de nombreuses situations :

- - Contournement des obstacle,

- - Automatisation de la planification des trajets,

- - Rechargement autonome.

Réalisation du Projet

Semaine 1 : 09-15 Septembre

Je me suis rendue mercredi au sein de l'entreprise Bonduelle à Villeneuve d'Ascq. Pour la réalisation de ce projet, Bonduelle m'a fourni un robot en Kit. J'ai commencé par le monter en suivant les instructions du mode d'emploi.

Une fois le robot monté, j'ai fait des recherches concernant les différents domaines de mon sujet :

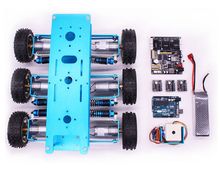

* Robot : De nos jours, on trouve de plus en plus de nombreux kits d'assemblage de robots programmables. C'est sur l'un d'entre eux, que je vais travailler dans le cadre de mon projet. Ce kit est commercialisé par la marque Yahboom. Ils vendent de nombreux modèles de robots : Char, Tank, des robots de 2 à des 6 roues. Celui sur lequel je vais travailler dans le cadre de mon projet est le robot Yahboom Professional 6WD UNO R3 smart robot kit compatible with Arduino Ce kit contient : Une caméra avant, 6 roues et 6 moteurs, une carte Arduino et une carte 6WD, une pile rechargeable.

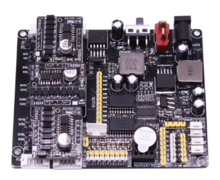

*Carte 6WD :

Yahboom 6WD carte d'extension intelligente pour Uno et Raspberry Pi. La carte d'extension 6WD est conçue avec trois prises d'entraînement de moteur et supporte jusqu'à trois modules d'entraînement de moteur. Chaque module peut conduire deux moteurs. Chaque moteur peut être contrôlé indépendamment, et 6 moteurs peuvent produire 6 vitesses différentes en même temps, réalisation contrôle indépendant. La carte d'extension 6WD prend en charge quatre contrôleurs populaires, y compris Raspberry Pi, Arduino, STM32, 51, etc.

Semaine 2 : 16 - 22 Septembre

Pendant la deuxième semaine de projet, j'ai majoritairement fait des recherches sur internet concernant mon projet. Le projet étant porté sur l’IA (Intelligence artificielle) et notamment les réseaux de neurones artificiels, la formation actuelle en IMA ne donne pas les connaissances nécessaires. Je vais donc passer une bonne partie du temps à me former pour apprendre son fonctionnement.

Recherche Machine Learning

- Un neurone artificiel peut se décomposer en :

- - Des entrées

- - Une fonction d’activation

- - Une sortie

On appelle potentiel du neurone la somme des entrées pondérées par leurs poids.

Si l’on a Xi la i−ème entrée d’un neurone et Wi le poids qui lui est associé, alors le potentiel du neurone est :

Fichier:P09 ML1.png

Pour calculer la sortie du neurone, on applique au potentiel une fonction qui peut être continue ou non.

Il est donc possible de connecter la sortie d’un neurone à l’une des entrées d’un autre neurone, c’est de cette façon que l’on peut former un réseau de neurone.

- Il existe ensuite plusieurs fonctions d’apprentissage, qui permettent de modifier les poids des connections entre les neurones. La modification des poids entraîne un changement dans la sortie du réseau de neurone. Il existe différents types d’apprentissage pour les réseaux de neurones :

- - Apprentissage supervisé : Plusieurs échantillons, représentant le contexte dans lequel se situe le neurone, sont présentés au réseau de neurones. Chaque échantillon est donné avec une sortie qui devrait être la même que la sortie calculée. Le réseau de neurone va alors se corriger selon la différence entre la sortie donnée et la sortie calculée par le réseau.

- - Apprentissage par renforcement : Plusieurs échantillons sont aussi présentés au réseau de neurones. Lorsque la sortie du réseau de neurone n’est pas celle voulue, le réseau est notifié de son erreur, mais aussi de sa réussite en cas de succès. Contrairement à l’apprentissage supervisé, le réseau ne peut pas connaître la valeur de son erreur en comparant sa sortie calculée avec une sortie donnée.

- - Apprentissage non supervisé : Lors de cet apprentissage, on présente aussi plusieurs échantillons. Cette fois-ci, le réseau essaye de dégager lui-même des caractéristiques communes à certaines entrées, pour répondre en conséquence. Le réseau établit lui-même différentes classes d’entrées.

Lecture de thèses

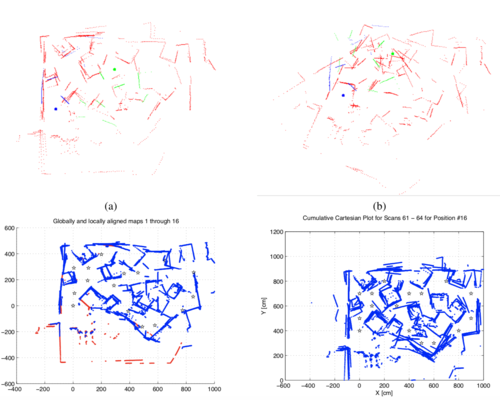

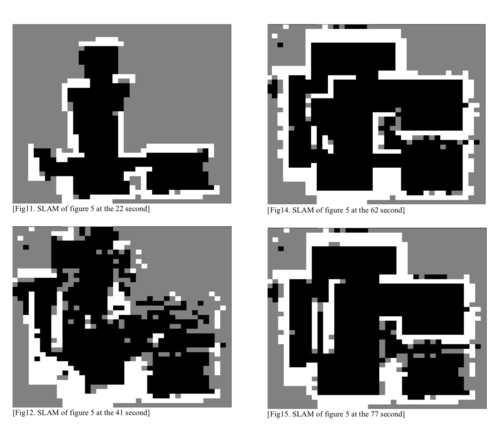

Construire une carte intérieure de façon autonome avec une auto localisation du robot dans la carte générée par ce dernier représente en ce moment un vrai point de recherche dans le domaine de la robotique mobile. Faire face à un environnement inconnu ou qui change est un problème qui se nomme SLAM (Simultaneous localization and mapping). C'est le sujet sur lequel porte cette recherche.

- Définition :

- - 'Odométrie ': Technique permettant d'estimer la position d'un véhicule en mouvement grâce à des capteurs embarqués permettant de mesurer le déplacement des roues du robot.

- Solution proposée par l'article : Faire correspondre les structures en utilisant la similarité des formes. Dans un premier temps, ils utilisent un laser range scanner (LIDAR/ Télémètre laser) qui génère un fichier de points. Par la suite ils font abstraction de la positions des points et utilisent les méthodes des tangentes et des histogrammes angulaires qui permettent de détecter les similitudes entre les scans.

- Définition :

- - Fuzzy Logic (FL) : Logique floue est une logique polyvalente où les valeurs de vérité des variables - au lieu d'être vrai ou faux - sont des réels entre 0 et 1. En ce sens, elle étend la logique booléenne classique avec des valeurs de vérités partielles. Elle consiste à tenir compte de divers facteurs numériques pour aboutir à une décision qui prend en compte plus de facteurs.

- - Adaptive neuro-fuzzy inference system (ANFIS) : Le système d'inférence neuro-fuzzy adaptatif ANFIS combine les avantages du réseau neuronal artificiel (ANN) et de la logique floue (FL), constituant ainsi un meilleur système d'approximation des fonctions non linéaires. Il a été proposé que ANFIS coopère avec EKF afin de réduire le déséquilibre entre la covariance théorique et réelle des séquences d’innovation. En fait, la qualité de l’estimation EKF est déterminée par les informations a priori des matrices de covariance de processus (Qk) et de bruit de mesure (Rk).

- - Simplified Complex-Value Neural Network (SCVNN) : La valeur complexe simplifiée Neuro-Floue égalise le nombre de couches de règles et de divisions dans la couche d'entrée. L'augmentation du nombre de paramètres d'entrée n'augmentera pas le nombre de règles. Dans l'intervalle, le format QNF simplifié permet à un réseau neuro-flou d'avoir une vitesse de calcul plus rapide avec moins de ressources occupées et un temps d'exécution moins important, indispensables à tout système informatique de grande taille en temps réel.

- - Extended Kalman Filter (EKF) : C'est une modélisation basée sur les fonctionnalités utilisant un algorithme de maximum de vraisemblance et une approche statistique pour l'association de données et l'association de données probabilistes. L'approche typique pour simuler la localisation et la cartographie en temps réel est généralement effectuée à l'aide de filtres de Kalman et de la méthode de Monte Carlo séquentielle, dans laquelle le résultat n'est pas satisfaisant en termes de quantité volumineuse d'entrées, de temps de traitement long et de performances médiocres en termes de précision. C'est depuis longtemps un algorithme populaire utilisé dans SLAM, en particulier avec les systèmes non linéaires.

- Solution proposée par l'article : Nouvelle approche pour la localisation du robot et la cartographie en vue d'améliorer le stockage des données d'entrées.

Semaine 3 : 23 - 29 Septembre

Premier pas du robo

Comment roule le robot ? Le robot possède 6 roues reliées à six moteurs à courant continu.

- - Un moteur à courant continu fonctionne à l'aide du principe de la PWM (Pulse Width Modulation), c'est de cette façon qu'il est possible d'agir sur la vitesse et le sens de rotation du moteur. Il faut utiliser les pins de sorties digitales de l'Arduino, on les reconnaît car elles ont le symbole " ~ ". On les commande avec une fonction de l'Arduino qui va prendre une valeur entre 0 et 255 :

analogWrite(pin,valeur);

où pin est le pin PWM choisi et mis en mode OUTPUT, et valeur est la valeur comprise entre 0 et 255 qui va définir la part de temps pendant laquelle le pin sera à l’état HAUT durant chaque intervalle (255 correspondra à 100% du temps d’intervalle à l’état HAUT)

- - Pour permettre le déplacement du robot, il faut lui fournir de l'énergie séparée pour l'Arduino et les moteurs. Ce principe est assez utilisé en électricité. Cela permet de séparer le circuit de commande et le circuit de puissance. Le circuit de commande envoie des informations binaires à une tension qui est celle de l'Arduino (+5 V) et un ampérage souvent faible (de l'ordre de 40 mA). L'alimentation de ce circuit est réalisée par une batterie (pile 9 V). Le circuit de puissance fournit l'énergie nécessaire pour faire fonctionner la charge.

Voici une vidéo qui montre les premiers déplacements du robot qui selon le code doit avancer reculer puis tourner:

Code

void setup(){

pinMode(pinMoteur,OUTPUT);

}

void loop(){

digitalWrite(pinMoteur,HIGH); //le moteur se lance

delay(1000);

digitalWrite(pinMoteur,LOW); //le moteur s'arrête

delay(1000);

}

Orientation du robot

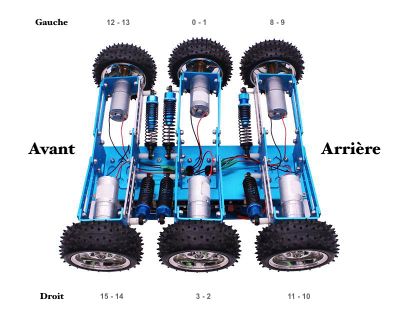

Pour permettre le déplacement du robot, il faut actionner les moteurs. Ci-dessous, une photo du robot:

A côté de chaque de roue, il y a deux numéros.

Prenons par exemple la roue avant droite, on peut lire " 15 - 14 ". Ces numéros représentent les pinMoteur, il y a deux valeurs : la première permet à la roue de tourner dans le sens anti-horaire (15) et la seconde dans le sens horaire (14).

Pour avancer, il faudra donc donner ces valeurs aux moteurs:

//Arrière pwm.setPWM(8, 0, Speed); pwm.setPWM(9, 0, 0); pwm.setPWM(11, 0, Speed); pwm.setPWM(10, 0, 0);

//Milieu pwm.setPWM(0, 0, Speed); pwm.setPWM(1, 0, 0); pwm.setPWM(3, 0, Speed); pwm.setPWM(2, 0, 0);

//Avant pwm.setPWM(12, 0, Speed); pwm.setPWM(13, 0, 0); pwm.setPWM(15, 0, Speed); pwm.setPWM(14, 0, 0);

Pour tourner à gauche, il faudra donc donner ces valeurs aux moteurs:

//Arrière pwm.setPWM(8, 0, Speed); pwm.setPWM(9, 0, 0); pwm.setPWM(11, 0, 0); pwm.setPWM(10, 0, Speed);

//Milieu pwm.setPWM(0, 0, Speed); pwm.setPWM(1, 0, 0); pwm.setPWM(3, 0, 0); pwm.setPWM(2, 0, Speed);

/Avant pwm.setPWM(12, 0, Speed); pwm.setPWM(13, 0, 0); pwm.setPWM(15, 0, 0); pwm.setPWM(14, 0, Speed);

J'ai donc une dizaine de fonctions qui me permettent de déplacer le robot.

Rendez-vous Bonduelle

Nous avons décidé de remplacer l'Arduino par un ESP32, un microprocesseur qui possède deux coeurs, ce qui lui permet de gérer simultanément deux tâches à la fois. Nous avons défini les objectifs pour les prochaines semaines et pour la première soutenance. Dans un premier temps, il faudra que je me concentre sur la réception et le traitement des données du LIDAR.

Lidar

L'entreprise propose un logiciel avec le LIDAR X4 qui fonctionne uniquement sous Windows. Ce logiciel permet visualiser les résultats du scan réalisé avec le LIDAR, avec une visualisation en 2D/3D des points. N'ayant pas de machine sous windows, il fallait trouver une autre façon de traiter les données.

Une autre méthode est de télécharger l'outil ROS (Robot Operating System) Kinetic. Cependant cet outil n'est pas opérationnel sous Debian, il est en cours d'expérimentation : le seul OS supporté est Ubuntu.

Un code est fourni avec le LIDAR et peut être téléchargé ici , voici les données récupérées :

On peut voir que un tour complet du LIDAR permet d'obtenir 656 valeurs de distances. Il y a donc en moyenne 1.8 mesures de distance par degrés.

Semaine 4 : 30 Septembre - 6 Octobre

Code Lidar

Cette semaine, l'objectif est de récupérer les données du LIDAR. J'ai modifié le fichier fourni par Ylidar afin d'afficher les valeurs de distances et d'angles. Ce fichier est codé en C++. C'est un langage que je ne connais pas encore, mais il s'apparente beaucoup au C, de nombreux sites tels que Stack Overflow me permettront de répondre à d'éventuelles questions.

Voici une partie du code qui permet de faire un Scan 360°, de l'arrêter et d'afficher les valeurs dans le terminal.

LaserScan scan;

if(laser.doProcessSimple(scan, hardError )){

for(int i =0; i < scan.ranges.size(); i++ ){

float angle = (scan.config.min_angle + i*scan.config.ang_increment)*180/3.14;

float dis = scan.ranges[I];

ydlidar::console.message("\tAngle: %.2f ° et Distance %.2f m ", angle,distance);

}

ydlidar::console.message("Scan received[%llu]: %u rangess",scan.self_time_stamp, (unsigned int)scan.ranges.size());

} else {

ydlidar::console.warning("Failed to get Lidar Data");

}

Récupération des données

Voici ce que je récupère:

J'ai ensuite modifié le code pour créer un fichier .txt et le remplir ligne par ligne avec les valeurs. Voici comment se présente une ligne: angle_value/distance_value.

Traitement des points

L'affichage du traitement des points s'effectuera sur une interface web. Le but de cette partie est de placer un point en fonction de son angle et de sa distance à partir de l'origine O placé au centre de la page web.

Voici la fonction qui s'en charge. En paramètre, les deux valeurs envoyées par le LIDAR. Pour placer le point, il faut déterminer son abscisse et son ordonnée. Pour les obtenir, on doit d'abord se placer au centre de la page web, définir l'échelle (équivalence entre les pixels de la page et la distance réelle en mètre) et utiliser les formules de trigonométrie : SOH CAH TOA.

| Positionnement d'un point |

|---|

function placerPoint(angle,distance){

ctx.beginPath();

var abscisse = centre_page_x + échelle * Math.cos(-angle*Math.PI/180) * distance;

var ordonnée = centre_page_y + échelle * Math.sin(-angle*Math.PI/180) * distance;

ctx.beginPath();

ctx.arc(x, y, point_size, 0, 2 * Math.PI);

ctx.fill();

}

|

Affichage de la cartographie

Je suis en train de me former pour coder un site en HTML et Javascript.

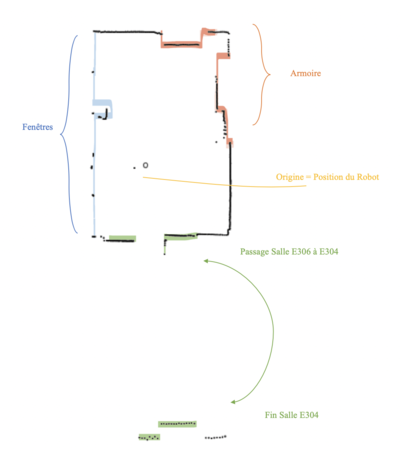

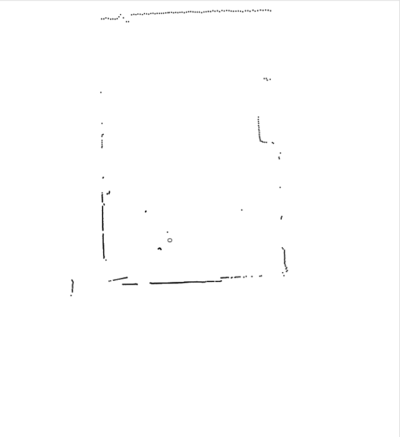

Une fois les données envoyées par le Lidar, il faut les afficher sur l'interface web., voici une première version de la cartographie :

Conditions de la capture des données :

- Le Lidar était positionné en hauteur afin d'éviter d'avoir des distances faussées par les différents objets de la salle (Ordinateurs, tours..)

- Position exacte Zabeth05 (représenté par le point O sur la cartographie)

Cette première version a été réalisée à Polytech dans la salle E306. On reconnait bien la disposition de la salle mais si ce n'est pas le cas voici ci-dessous l'image légendée pour se mieux visualiser la pièce.

Analyse de cette première version :

- Les angles morts ne sont pas traitées (exemple : les armoires)

- Les fenêtres sont mal représentées car il n'y a pas de réflexion du laser.

Raspberry Pi

En fin de semaine, j'ai travaillé à Bonduelle. J'ai choisi de télécharger l'image Ubuntu Mate 18.05 parce que ROS n'est disponible que sous Ubuntu. J'ai installé tous les packages nécessaires.

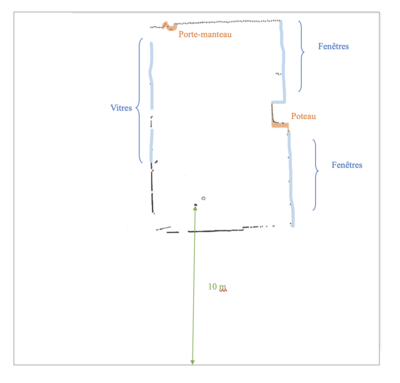

J'ai ensuite récupéré les fichiers de code et réussi à les exécuter sur la Raspberry Pi. J'ai cartographie le bureau où je travaille à Bonduelle et en l'analysant je peux confirmer les premières observations faites dans la salle E306 : le Lidar a du mal à cartographier les vitres. Voici le résultat non commenté et commenté pour avoir une idée précise de la pièce.

Voici le résultat :

|

|

Semaines 5 et 6 : 7-20 Octobre

L'objectif de ces deux prochaines semaines est :

- de pouvoir lancer la cartographie à distance : sur un autre ordinateur connecté sur le même réseau

- d'améliorer le fonctionnement précédent : changer le format du fichier où l'on enregistre les données TXT -> JSON

- Premier croquis du site final

- ROS

L'installation de ROS n'est finalement pas supporté sur UBUNTU Mate l'OS de la Raspberry pi. Ce n'est pas grave parce que l'objectif n'est pas de récupérer un outils qui fait déjà la cartographie, mais plutôt que je le réalise seule. Cependant voici ce que cet outil informatique est capable de faire :

[Lien] de la photo. Cartographer est un système qui assure la localisation et la cartographie simultanées (SLAM) en 2D et 3D sur plusieurs plates-formes et configurations de capteurs. Le rendu est assez impressionnant.

- Lancer l'acquisition à distance

- Changement de fichier

Une fois que j'ai compris comment enregistrer des données (en TXT), les interpréter et dessiner les points sur un site, il est préférable maintenant de passer au format de données JSON. En effet cela me permettra de récupérer les données facilement et les enregistrer dans une structure automatiquement avec les méthodes prévues en JS. C'est assez simple d'utiliser JSON en C++. Il faut d'abord réfléchir à la structure de ses données, j'aimerai avoir la suivante:

{

"0" : {

"angle" : "-180",

"distance" : "2.08"

},

"1" : {

"angle" : "-179",

"distance" : "2.0"

},

...

}

Voici le code pour avoir cette structure :

#include <jsoncpp/json/json.h>

file.open("lidar.json");

Json::StyledWriter styledWriter;

Json::Value lidarValues;

// boucle pour chaque valeur reçues

lidarValues[to_string(i)]["angle"]=to_string(angle);

lidarValues[to_string(i)]["distance"]=to_string(dis);

Pour compiler le fichier main.cpp, il faut ajouter la librairie 'ljsoncpp' ans la commande :

g++ -o profile profile.cpp -ljsoncpp

Cependant dans mon projet, j'ai un premier Makefile qui en lance un second qui en lance un Cmake, chaque fichier continent 400 lignes. Je n'avais pas vraiment la main pour ajouter cette librairie. J'ai fait pas mal de recherches et j'ai étudier tous les fichiers sans trouver comment ajouter cette librairie. J'ai alors repris le [git] du LIDAR et j'ai tout repris depuis le départ. Lorsqu'on clone le projet, il faut créer le dossier build, et lancer cette commande lorsqu'on se situe dans le dossier.

cmake ../sdk

Le fichier CMakeLists.txt était le seul que je n'avais pas étudier. C'est donc dans ce fichier qu'il faut rajouter la ligne:

target_link_libraries(ydlidar_driver ljsoncpp)

- Croquis du site final

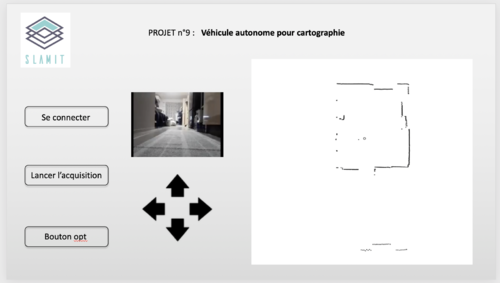

Voici un croquis du site que je souhaite réaliser:

Depuis la création du projet, j'ai choisi le nom du robot: SLAMiT. SLAM (simultaneous localization and mapping) fait référence à la cartographie et la localisation simultanées.

L'objectif serait d'avoir une interface simple dans un premier temps, qui permettrai de:

- Voir le retour caméra du robot

- Utiliser des flèches pour déplacer le robot à distance

- La cartographie de la pièce ou se trouve le robot

- Quelques boutons

Exemple d'utilisation :

L'utilisateur se rend sur la page du projet, il se connecte au robot avec le bouton n°1. Il voit alors le retour de la caméra du robot, et il peut aussi déplacer le robot. Lorsqu'il appuie sur lancer l'acquisition, il doit avoir la cartographie avec le point O qui représente la localisation du robot dans sa cartographie. Le but serait de superposer les cartographie pour avoir un rendu précis et régler le problème des angles morts.

Semaine 7 : 21 Octobre - 3 Novembre

Les objectifs de la 7ème semaine et la semaine de la Toussaint sont les suivants :

- Réaliser une première version du site en suivant l'idée du croquis

- Lancer l'acquisition de la cartographie à distance

- Déplacer le robot à distance

Réalisation du site

Voici une image du site:

Dans un premier temps, je ne m'intéresse pas au design du site. Je préfère travailler le fond avant la forme. Concernant le robot, il y a 5 boutons:

- Se connecter et se déconnecter: Le titre de la page permet d'avoir des informations sur cette connexion. S'il est vert, la connection est établie, sinon il faut il faut cliquer sur le bouton 'se connecter'. Si l'on souhaite se déconnecter au robot, il faut cliquer sur le bouton 'se déconnecter', le titre devient alors rouge.

- Déplacement du robot : Il y a trois boutons pour le moments 'Avancer', 'Reculer', 'Tourner'. Ils permettront de commander le robot à distance.

Cartographie

Le lancement de la cartographie la semaine dernière fonctionnait, mais il affichait le résultat de l'exécution du fichier PHP. Il faudrait maintenant que lorsque l'utilisateur appuie sur le bouton 'Lancer l'acquisition' :

- En arrière plan : exécution du fichier .php qui permet au LIDAR de se lancer et d'enregistrer les données dans un fichier JSON

- Cette exécution en arrière plan doit permettre à l'utilisateur de rester sur la page du site

- Lorsque le fichier est prêt le site affiche automatiquement la nouvelle cartographie.

Déplacement du robot

Pour permettre la communication entre le robot (Arduino) et la Raspberry Pi, je vais utiliser des