IMA5 2019/2020 P09 : Différence entre versions

m (→Semaines 5 et 6) |

(→Semaine 21 : 17 - 21 Février (Soutenance 2)) |

||

| (110 révisions intermédiaires par 2 utilisateurs non affichées) | |||

| Ligne 27 : | Ligne 27 : | ||

Matériel mis à disposition par '''Polytech :''' | Matériel mis à disposition par '''Polytech :''' | ||

| − | + | * VL6180X Distance Sensor | |

| + | * Carte Raspberry Pi 3GB | ||

Matériels mis à disposition par '''Bonduelle :''' | Matériels mis à disposition par '''Bonduelle :''' | ||

| − | + | * Robot kit : [https://category.yahboom.net/collections/r-6wd-robot/products/ar6wdrobot/ Yahboom Professional 6WD UNO R3 smart robot kit compatible with Arduino] | |

| − | + | * Carte Arduino fournie dans le kit | |

| − | + | * Lidar 3D : [https://www.amazon.fr/Lidar-053-Eai-Ydlidar-X4-Lidar-Fréquence-Ydlidar-x4/dp/B07DBYHJVQ/ Lidar-053 Eai Ydlidar X4 Lidar Laser Radar Scanner ] | |

| − | + | * Carte Raspberry Pi 4GB et carte SD | |

| − | + | * Kit pour déplacement caméra suivant deux axes | |

== Questions == | == Questions == | ||

| Ligne 66 : | Ligne 67 : | ||

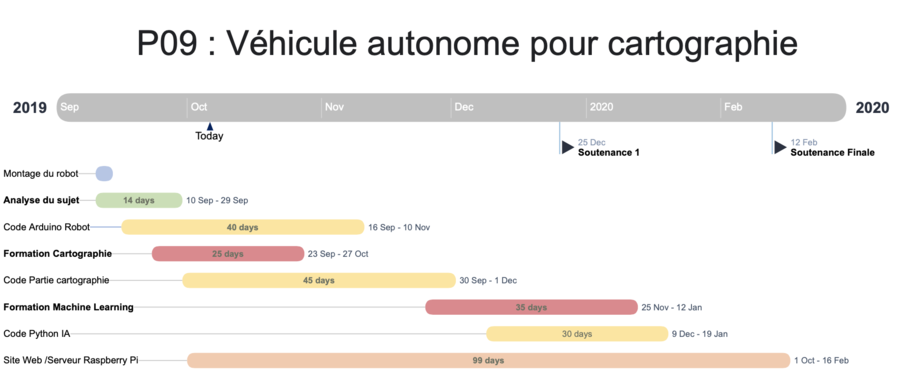

==Liste des tâches à effectuer== | ==Liste des tâches à effectuer== | ||

{| class="wikitable" | {| class="wikitable" | ||

| − | !Tâche !! | + | !Tâche \ Heures !! S01 !! S02 !! S03 !! S04 !! S05 |

| + | S06 | ||

| + | ! S07 !! S08 | ||

| + | S11 | ||

| + | ! S12 !! S13 | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | '''S14''' | ||

| + | '''Oral 1''' | ||

| + | ! S15 | ||

| + | S16 | ||

| + | ! S17 | ||

| + | S18 | ||

| + | ! S19 !! S20 | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | '''S21''' | ||

| + | '''Oral 2''' | ||

| + | !Total | ||

| + | |- | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | '''Analyse''' | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

|- | |- | ||

| Analyse du projet | | Analyse du projet | ||

| Ligne 75 : | Ligne 108 : | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| | | | ||

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | |style="text-align:center;" | | + | |style="text-align:center;" |7 |

|- | |- | ||

| Recherches concernant le projet | | Recherches concernant le projet | ||

| Ligne 92 : | Ligne 126 : | ||

|style="text-align:center;" bgcolor="#B0F2B6" | 2 | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| | | | ||

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | | | + | |style="text-align:center;" bgcolor="#D3D3D3" | |

| − | |style="text-align:center;" | | + | |style="text-align:center;" | 8 |

|- | |- | ||

| Montage du robot | | Montage du robot | ||

| Ligne 106 : | Ligne 141 : | ||

| style="text-align:center;" bgcolor="#D3D3D3" | | | style="text-align:center;" bgcolor="#D3D3D3" | | ||

| style="text-align:center;" bgcolor="#D3D3D3" | | | style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

|style="text-align:center;" bgcolor="#D3D3D3" | | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

|style="text-align:center;" bgcolor="#D3D3D3" | | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| Ligne 118 : | Ligne 154 : | ||

|style="text-align:center;" bgcolor="#D3D3D3" | | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

|style="text-align:center;" |2 | |style="text-align:center;" |2 | ||

| + | |- | ||

| + | | Modélisation et Impression 3D | ||

| + | | style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | | style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | | style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | | style="text-align:center;" bgcolor="#B0F2B6" | 5 | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | |style="text-align:center;" |5 | ||

| + | |- | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | '''Formation - Documentation''' | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |- | ||

| + | |||

| + | | Formation Machine Learning | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | | | ||

| + | | | ||

| + | |style="text-align:center;" | 6 | ||

|- | |- | ||

| Formation Partie Cartographie (LIDAR) | | Formation Partie Cartographie (LIDAR) | ||

| Ligne 126 : | Ligne 217 : | ||

| style="text-align:center;" bgcolor="#B0F2B6" | 3 | | style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| | | | ||

| + | | | ||

| | | | ||

| | | | ||

| Ligne 136 : | Ligne 228 : | ||

|style="text-align:center;" | 9 | |style="text-align:center;" | 9 | ||

|- | |- | ||

| − | | | + | | Formation Computer Vision |

| + | | | ||

| | | | ||

| | | | ||

| − | |||

| | | | ||

| | | | ||

| + | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 10 | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | |style="text-align:center;" | 10 | ||

| + | |- | ||

| + | | Formation ROS | ||

| | | | ||

| | | | ||

| + | | | ||

| | | | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 10 | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 8 | ||

| | | | ||

| | | | ||

| − | |style="text-align:center;" | 3 | + | | |

| + | | | ||

| + | |style="text-align:center;" | 22 | ||

| + | |- | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | '''Code''' | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |- | ||

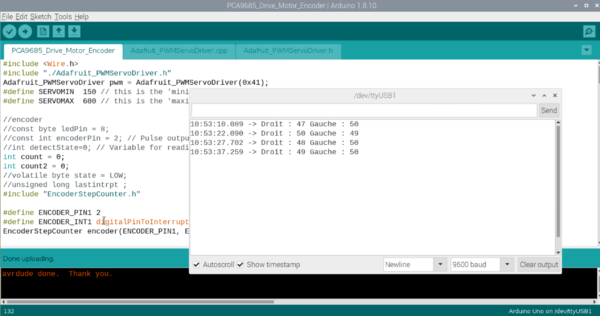

| + | | Code Arduino | ||

| + | | | ||

| + | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| + | | | ||

| + | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| + | | | ||

| + | | | ||

| + | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 7 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | | | ||

| + | |style="text-align:center;" | 19 | ||

|- | |- | ||

| Code C++ : Lidar | | Code C++ : Lidar | ||

| Ligne 159 : | Ligne 306 : | ||

|style="text-align:center;" bgcolor="#B0F2B6" | 2 | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

|style="text-align:center;" bgcolor="#B0F2B6" | 4 | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | | | ||

| | | | ||

| | | | ||

| Ligne 176 : | Ligne 324 : | ||

|style="text-align:center;" bgcolor="#B0F2B6" | 3 | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

|style="text-align:center;" bgcolor="#B0F2B6" | 4 | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| | | | ||

| | | | ||

| Ligne 181 : | Ligne 331 : | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | | | ||

| + | |style="text-align:center;" | 17 | ||

| + | |- | ||

| + | | Code Python : Open CV | ||

| + | | | ||

| + | | | ||

| | | | ||

| | | | ||

| | | | ||

| | | | ||

| − | |style="text-align:center;" | | + | |style="text-align:center;" bgcolor="#B0F2B6" | 8 |

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" |8 | ||

|- | |- | ||

| − | | | + | | Code ROS |

| − | | | + | | |

| − | + | | | |

| − | | | ||

| − | |||

| − | |||

| | | | ||

| | | | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 5 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 5 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| | | | ||

| + | |style="text-align:center;" |21 | ||

| + | |- | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | '''Rencontre Tuteurs''' | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |- | ||

| + | | Rencontre Bonduelle | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 1 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 1 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | | style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | | style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| | | | ||

| − | |style="text-align:center;" | | + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 |

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" | 32 | ||

| + | |- | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | '''Documentation''' | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | | style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

|- | |- | ||

| Remplissage du wiki | | Remplissage du wiki | ||

| Ligne 210 : | Ligne 432 : | ||

|style="text-align:center;" bgcolor="#B0F2B6" | 3 | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

|style="text-align:center;" bgcolor="#B0F2B6" | 3 | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 1 | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| | | | ||

| | | | ||

| | | | ||

| − | | | + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 |

| − | + | |style="text-align:center;" |21 | |

| − | |||

| − | | | ||

| − | |style="text-align:center;" | | ||

|- | |- | ||

| − | | | + | | Documentation pour Bonduelle |

| − | |||

| | | | ||

| − | |||

| | | | ||

| | | | ||

| Ligne 230 : | Ligne 451 : | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| | | | ||

| | | | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 1 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| | | | ||

| − | + | |style="text-align:center;" | 9 | |

| − | |style="text-align:center;" | | ||

|- | |- | ||

| − | | | + | | Préparation Soutenance 1 |

| | | | ||

| | | | ||

| Ligne 244 : | Ligne 468 : | ||

| | | | ||

| | | | ||

| − | |||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 3 | ||

| + | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" | 9 | ||

| + | |- | ||

| + | | Préparation Soutenance 2 | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | | style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| | | | ||

| | | | ||

| | | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| | | | ||

| + | |style="text-align:center;" | 2 | ||

| + | |- | ||

| + | | Rédaction du rapport (Interm et Final) | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | | style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#D3D3D3" | | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| | | | ||

| | | | ||

| | | | ||

| − | |style="text-align:center;" | | + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 |

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 4 | ||

| + | |style="text-align:center;" bgcolor="#B0F2B6" | 2 | ||

| + | |style="text-align:center;" | 16 | ||

|- | |- | ||

!scope=col style="text-align:center;" | Total | !scope=col style="text-align:center;" | Total | ||

| Ligne 261 : | Ligne 522 : | ||

!scope=col style="text-align:center;" | 12 | !scope=col style="text-align:center;" | 12 | ||

!scope=col style="text-align:center;" | 20 | !scope=col style="text-align:center;" | 20 | ||

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 13 |

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 43 |

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 15 |

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 8 |

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 12 |

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 26 |

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 15 |

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 15 |

| − | !scope=col style="text-align:center;" | | + | !scope=col style="text-align:center;" | 23 |

| + | !scope=col style="text-align:center;" | 7 | ||

|style="text-align:center;" bgcolor="#A1D4E5" | | |style="text-align:center;" bgcolor="#A1D4E5" | | ||

|} | |} | ||

| Ligne 336 : | Ligne 598 : | ||

Pour calculer la sortie du neurone, on applique au potentiel une fonction qui peut être continue ou non. | Pour calculer la sortie du neurone, on applique au potentiel une fonction qui peut être continue ou non. | ||

Il est donc possible de connecter la sortie d’un neurone à l’une des entrées d’un autre neurone, c’est de cette façon que l’on peut former un réseau de neurone. <br> | Il est donc possible de connecter la sortie d’un neurone à l’une des entrées d’un autre neurone, c’est de cette façon que l’on peut former un réseau de neurone. <br> | ||

| − | * Il existe ensuite plusieurs fonctions d’apprentissage, qui permettent de modifier les poids des | + | * Il existe ensuite plusieurs fonctions d’apprentissage, qui permettent de modifier les poids des connexions entre les neurones. La modification des poids entraîne un changement dans la sortie du réseau de neurone. Il existe différents types d’apprentissage pour les réseaux de neurones : |

::- '''Apprentissage supervisé''' : Plusieurs échantillons, représentant le contexte dans lequel se situe le neurone, sont présentés au réseau de neurones. Chaque échantillon est donné avec une sortie qui devrait être la même que la sortie calculée. Le réseau de neurone va alors se corriger selon la différence entre la sortie donnée et la sortie calculée par le réseau. | ::- '''Apprentissage supervisé''' : Plusieurs échantillons, représentant le contexte dans lequel se situe le neurone, sont présentés au réseau de neurones. Chaque échantillon est donné avec une sortie qui devrait être la même que la sortie calculée. Le réseau de neurone va alors se corriger selon la différence entre la sortie donnée et la sortie calculée par le réseau. | ||

::- '''Apprentissage par renforcement''' : Plusieurs échantillons sont aussi présentés au réseau de neurones. Lorsque la sortie du réseau de neurone n’est pas celle voulue, le réseau est notifié de son erreur, mais aussi de sa réussite en cas de succès. Contrairement à l’apprentissage supervisé, le réseau ne peut pas connaître la valeur de son erreur en comparant sa sortie calculée avec une sortie donnée. | ::- '''Apprentissage par renforcement''' : Plusieurs échantillons sont aussi présentés au réseau de neurones. Lorsque la sortie du réseau de neurone n’est pas celle voulue, le réseau est notifié de son erreur, mais aussi de sa réussite en cas de succès. Contrairement à l’apprentissage supervisé, le réseau ne peut pas connaître la valeur de son erreur en comparant sa sortie calculée avec une sortie donnée. | ||

| Ligne 353 : | Ligne 615 : | ||

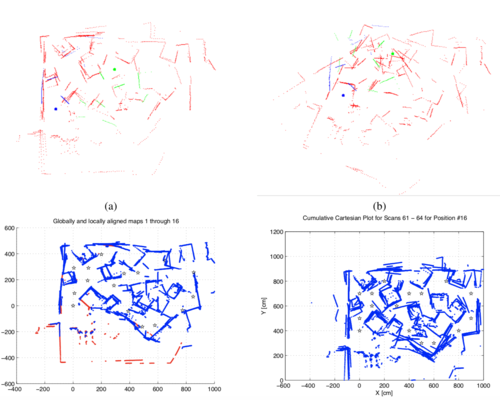

* Solution proposée par l'article : Faire correspondre les structures en utilisant la similarité des formes. Dans un premier temps, ils utilisent un laser range scanner (LIDAR/ Télémètre laser) qui génère un fichier de points. Par la suite ils font abstraction de la positions des points et utilisent les méthodes des tangentes et des histogrammes angulaires qui permettent de détecter les similitudes entre les scans. | * Solution proposée par l'article : Faire correspondre les structures en utilisant la similarité des formes. Dans un premier temps, ils utilisent un laser range scanner (LIDAR/ Télémètre laser) qui génère un fichier de points. Par la suite ils font abstraction de la positions des points et utilisent les méthodes des tangentes et des histogrammes angulaires qui permettent de détecter les similitudes entre les scans. | ||

| + | |||

| + | |||

| + | [[Fichier:P9_these1.png |center ||500px]] | ||

| Ligne 368 : | Ligne 633 : | ||

* Solution proposée par l'article : Nouvelle approche pour la localisation du robot et la cartographie en vue d'améliorer le stockage des données d'entrées. | * Solution proposée par l'article : Nouvelle approche pour la localisation du robot et la cartographie en vue d'améliorer le stockage des données d'entrées. | ||

| + | |||

| + | |||

| + | [[Fichier:P9_these2.png |center ||500px]] | ||

==Semaine 3 : 23 - 29 Septembre == | ==Semaine 3 : 23 - 29 Septembre == | ||

| − | + | === Premier pas du robot === | |

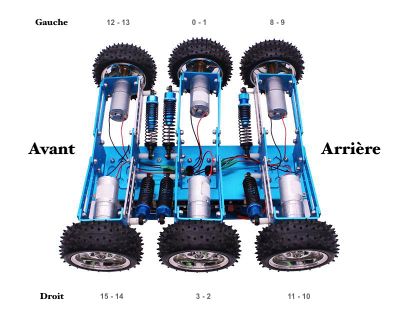

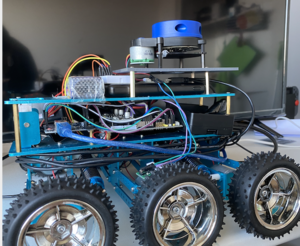

Comment roule le robot ? Le robot possède 6 roues reliées à six moteurs à courant continu. | Comment roule le robot ? Le robot possède 6 roues reliées à six moteurs à courant continu. | ||

| Ligne 380 : | Ligne 648 : | ||

::- Pour permettre le déplacement du robot, il faut lui fournir de '''l'énergie''' séparée pour l'Arduino et les moteurs. Ce principe est assez utilisé en électricité. Cela permet de séparer le circuit de commande et le circuit de puissance. Le circuit de commande envoie des informations binaires à une tension qui est celle de l'Arduino (+5 V) et un ampérage souvent faible (de l'ordre de 40 mA). L'alimentation de ce circuit est réalisée par une batterie (pile 9 V). Le circuit de puissance fournit l'énergie nécessaire pour faire fonctionner la charge. | ::- Pour permettre le déplacement du robot, il faut lui fournir de '''l'énergie''' séparée pour l'Arduino et les moteurs. Ce principe est assez utilisé en électricité. Cela permet de séparer le circuit de commande et le circuit de puissance. Le circuit de commande envoie des informations binaires à une tension qui est celle de l'Arduino (+5 V) et un ampérage souvent faible (de l'ordre de 40 mA). L'alimentation de ce circuit est réalisée par une batterie (pile 9 V). Le circuit de puissance fournit l'énergie nécessaire pour faire fonctionner la charge. | ||

| − | [[Fichier:P09-robot.gif]] | + | Voici un gif qui montre les premiers déplacements du robot qui selon le code doit avancer reculer puis tourner: |

| + | [[Fichier:P09-robot.gif| center| 300 px]] | ||

| − | + | ===Code === | |

void setup(){ | void setup(){ | ||

pinMode(pinMoteur,OUTPUT); | pinMode(pinMoteur,OUTPUT); | ||

| Ligne 394 : | Ligne 663 : | ||

| − | ' | + | === Orientation du robot === |

| + | |||

| + | Pour permettre le déplacement du robot, il faut actionner les moteurs. Ci-dessous, une photo du robot: | ||

| + | |||

| + | [[Fichier:P9_orientationRobot.jpeg|center|400px]] | ||

| + | |||

| + | A côté de chaque de roue, il y a deux numéros. | ||

| + | |||

| + | Prenons par exemple la roue avant droite, on peut lire " 15 - 14 ". Ces numéros représentent les pinMoteur, il y a deux valeurs : la première permet à la roue de tourner dans le sens anti-horaire (15) et la seconde dans le sens horaire (14). | ||

| + | |||

| + | Pour avancer, il faudra donc donner ces valeurs aux moteurs: | ||

| + | //Arrière | ||

| + | pwm.setPWM(8, 0, Speed); | ||

| + | pwm.setPWM(9, 0, 0); | ||

| + | pwm.setPWM(11, 0, Speed); | ||

| + | pwm.setPWM(10, 0, 0); | ||

| + | |||

| + | //Milieu | ||

| + | pwm.setPWM(0, 0, Speed); | ||

| + | pwm.setPWM(1, 0, 0); | ||

| + | pwm.setPWM(3, 0, Speed); | ||

| + | pwm.setPWM(2, 0, 0); | ||

| + | |||

| + | //Avant | ||

| + | pwm.setPWM(12, 0, Speed); | ||

| + | pwm.setPWM(13, 0, 0); | ||

| + | pwm.setPWM(15, 0, Speed); | ||

| + | pwm.setPWM(14, 0, 0); | ||

| + | |||

| + | Pour tourner à gauche, il faudra donc donner ces valeurs aux moteurs: | ||

| + | //Arrière | ||

| + | pwm.setPWM(8, 0, Speed); | ||

| + | pwm.setPWM(9, 0, 0); | ||

| + | pwm.setPWM(11, 0, 0); | ||

| + | pwm.setPWM(10, 0, Speed); | ||

| + | |||

| + | //Milieu | ||

| + | pwm.setPWM(0, 0, Speed); | ||

| + | pwm.setPWM(1, 0, 0); | ||

| + | pwm.setPWM(3, 0, 0); | ||

| + | pwm.setPWM(2, 0, Speed); | ||

| + | |||

| + | /Avant | ||

| + | pwm.setPWM(12, 0, Speed); | ||

| + | pwm.setPWM(13, 0, 0); | ||

| + | pwm.setPWM(15, 0, 0); | ||

| + | pwm.setPWM(14, 0, Speed); | ||

| + | |||

| + | |||

| + | J'ai donc une dizaine de fonctions qui me permettent de déplacer le robot. | ||

| + | |||

| + | === Rendez-vous Bonduelle === | ||

Nous avons décidé de remplacer l'Arduino par un ESP32, un microprocesseur qui possède deux coeurs, ce qui lui permet de gérer simultanément deux tâches à la fois. Nous avons défini les objectifs pour les prochaines semaines et pour la première soutenance. Dans un premier temps, il faudra que je me concentre sur la réception et le traitement des données du LIDAR. | Nous avons décidé de remplacer l'Arduino par un ESP32, un microprocesseur qui possède deux coeurs, ce qui lui permet de gérer simultanément deux tâches à la fois. Nous avons défini les objectifs pour les prochaines semaines et pour la première soutenance. Dans un premier temps, il faudra que je me concentre sur la réception et le traitement des données du LIDAR. | ||

| Ligne 400 : | Ligne 720 : | ||

| − | + | === Lidar === | |

| − | L'entreprise propose un logiciel avec le LIDAR X4 qui fonctionne uniquement sous Windows. Ce logiciel permet visualiser les résultats du scan réalisé avec le LIDAR, avec une visualisation en 2D/3D des points. | + | L'entreprise propose un logiciel avec le LIDAR X4 qui fonctionne uniquement sous Windows. Ce logiciel permet de visualiser les résultats du scan réalisé avec le LIDAR, avec une visualisation en 2D/3D des points. |

N'ayant pas de machine sous windows, il fallait trouver une autre façon de traiter les données. | N'ayant pas de machine sous windows, il fallait trouver une autre façon de traiter les données. | ||

| Ligne 413 : | Ligne 733 : | ||

|} | |} | ||

| − | On peut voir | + | On peut voir qu'un tour complet du LIDAR permet d'obtenir 656 valeurs de distances. Il y a donc en moyenne 1.8 mesures de distance par degrés. |

==Semaine 4 : 30 Septembre - 6 Octobre == | ==Semaine 4 : 30 Septembre - 6 Octobre == | ||

| − | === | + | |

| + | === Code Lidar === | ||

Cette semaine, l'objectif est de récupérer les données du LIDAR. J'ai modifié le fichier fourni par Ylidar afin d'afficher les valeurs de distances et d'angles. | Cette semaine, l'objectif est de récupérer les données du LIDAR. J'ai modifié le fichier fourni par Ylidar afin d'afficher les valeurs de distances et d'angles. | ||

Ce fichier est codé en C++. C'est un langage que je ne connais pas encore, mais il s'apparente beaucoup au C, de nombreux sites tels que Stack Overflow me permettront de répondre à d'éventuelles questions. | Ce fichier est codé en C++. C'est un langage que je ne connais pas encore, mais il s'apparente beaucoup au C, de nombreux sites tels que Stack Overflow me permettront de répondre à d'éventuelles questions. | ||

| + | |||

| + | Voici une partie du code qui permet de faire un Scan 360°, de l'arrêter et d'afficher les valeurs dans le terminal. | ||

| + | LaserScan scan; | ||

| + | if(laser.doProcessSimple(scan, hardError )){ | ||

| + | for(int i =0; i < scan.ranges.size(); i++ ){ | ||

| + | float angle = (scan.config.min_angle + i*scan.config.ang_increment)*180/3.14; | ||

| + | float dis = scan.ranges[I]; | ||

| + | ydlidar::console.message("\tAngle: %.2f ° et Distance %.2f m ", angle,distance); | ||

| + | } | ||

| + | ydlidar::console.message("Scan received[%llu]: %u rangess",scan.self_time_stamp, (unsigned int)scan.ranges.size()); | ||

| + | } else { | ||

| + | ydlidar::console.warning("Failed to get Lidar Data"); | ||

| + | } | ||

| + | |||

| + | |||

| + | === Récupération des données === | ||

Voici ce que je récupère: | Voici ce que je récupère: | ||

| Ligne 454 : | Ligne 791 : | ||

| − | Je suis | + | Je suis en train de me former pour coder un site en HTML et Javascript. |

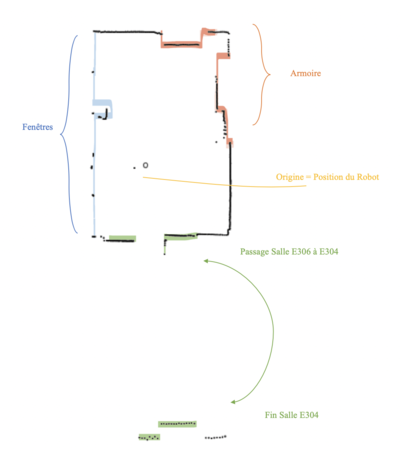

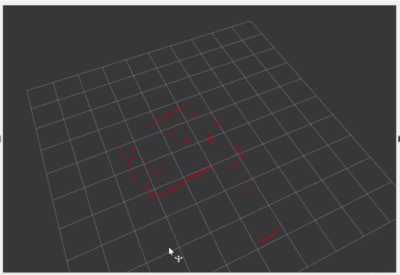

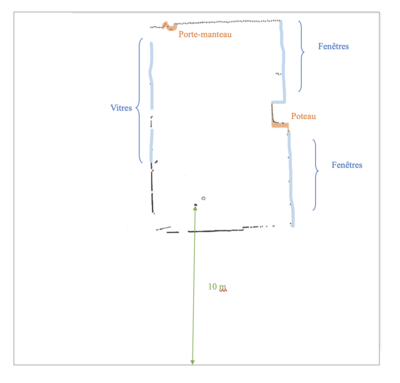

Une fois les données envoyées par le Lidar, il faut les afficher sur l'interface web., voici une première version de la cartographie : | Une fois les données envoyées par le Lidar, il faut les afficher sur l'interface web., voici une première version de la cartographie : | ||

| Ligne 465 : | Ligne 802 : | ||

* Position exacte Zabeth05 (représenté par le point O sur la cartographie) | * Position exacte Zabeth05 (représenté par le point O sur la cartographie) | ||

| − | Cette première version a été réalisée à Polytech dans la salle E306. On | + | Cette première version a été réalisée à Polytech dans la salle E306. On reconnaît bien la disposition de la salle mais si ce n'est pas le cas voici ci-dessous l'image légendée pour se mieux visualiser la pièce. |

| Ligne 479 : | Ligne 816 : | ||

Analyse de cette première version : | Analyse de cette première version : | ||

| − | * Les angles morts ne sont pas | + | * Les angles morts ne sont pas traités (exemple : les armoires) |

* Les fenêtres sont mal représentées car il n'y a pas de réflexion du laser. | * Les fenêtres sont mal représentées car il n'y a pas de réflexion du laser. | ||

| Ligne 509 : | Ligne 846 : | ||

| − | + | ===ROS=== | |

| − | L'installation de ROS n'est finalement pas | + | L'installation de ROS n'est finalement pas supportée sur UBUNTU Mate l'OS de la Raspberry pi. Ce n'est pas grave parce que l'objectif n'est pas de récupérer un outil qui fait déjà la cartographie, mais plutôt que je le réalise seule. |

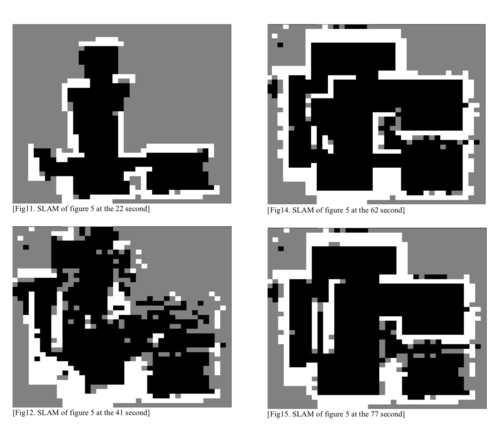

Cependant voici ce que cet outil informatique est capable de faire : | Cependant voici ce que cet outil informatique est capable de faire : | ||

| Ligne 518 : | Ligne 855 : | ||

[[https://google-cartographer-ros.readthedocs.io/en/latest/ Lien]] de la photo. Cartographer est un système qui assure la localisation et la cartographie simultanées (SLAM) en 2D et 3D sur plusieurs plates-formes et configurations de capteurs. Le rendu est assez impressionnant. | [[https://google-cartographer-ros.readthedocs.io/en/latest/ Lien]] de la photo. Cartographer est un système qui assure la localisation et la cartographie simultanées (SLAM) en 2D et 3D sur plusieurs plates-formes et configurations de capteurs. Le rendu est assez impressionnant. | ||

| − | + | ===Lancer l'acquisition à distance=== | |

| + | Voici le code qui me permet de lancer l'acquisition à distance (depuis mon ordinateur connecté sur le même réseau que la Raspberry Pi) : | ||

| + | |||

| + | * Fichier HTML | ||

| + | <body> | ||

| + | <form action="lidar.php" method="post"> | ||

| + | <input type="submit" name="lidar" value="Start"/> | ||

| + | </form> | ||

| + | </body> | ||

| + | * Fichier PHP | ||

| + | <?php | ||

| + | define('LIDAR_ON','/home/lmejbar/Lidar/ydlidar-master/build/samples/ydlidar_test'); | ||

| + | if(array_key_exists('lidar',$_REQUEST)){ | ||

| + | $lidar=$_REQUEST['lidar']; | ||

| + | if($lidar=="Lancer l'aquisition") exec(LIDAR_ON); | ||

| + | header('Location: http://192.168.0.20/serial.html'); | ||

| + | exit(); | ||

| + | } | ||

| + | ?> | ||

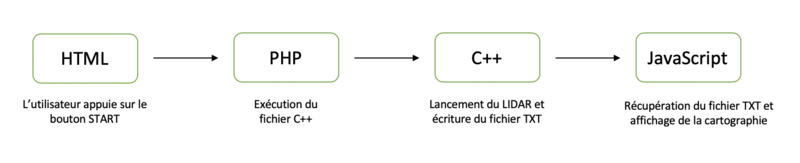

| − | + | Voici le fonctionnement : | |

| + | |||

| + | [[Fichier:P9_Foncitonnement_acquisitionadistance.png|center|800px]] | ||

| + | |||

| + | |||

| + | |||

| + | ===Changement de fichier === | ||

Une fois que j'ai compris comment enregistrer des données (en TXT), les interpréter et dessiner les points sur un site, il est préférable maintenant de passer au format de données JSON. En effet cela me permettra de récupérer les données facilement et les enregistrer dans une structure automatiquement avec les méthodes prévues en JS. | Une fois que j'ai compris comment enregistrer des données (en TXT), les interpréter et dessiner les points sur un site, il est préférable maintenant de passer au format de données JSON. En effet cela me permettra de récupérer les données facilement et les enregistrer dans une structure automatiquement avec les méthodes prévues en JS. | ||

| − | C'est assez simple d'utiliser JSON en C++. Il faut d'abord réfléchir à la structure de ses données, j' | + | C'est assez simple d'utiliser JSON en C++. Il faut d'abord réfléchir à la structure de ses données, j'aimerais avoir la suivante: |

{ | { | ||

"0" : { | "0" : { | ||

| Ligne 547 : | Ligne 908 : | ||

lidarValues[to_string(i)]["distance"]=to_string(dis); | lidarValues[to_string(i)]["distance"]=to_string(dis); | ||

| − | Pour compiler le fichier main.cpp, il faut ajouter la librairie 'ljsoncpp' | + | Pour compiler le fichier main.cpp, il faut ajouter la librairie 'ljsoncpp' dans la commande : |

g++ -o profile profile.cpp -ljsoncpp | g++ -o profile profile.cpp -ljsoncpp | ||

| − | Cependant dans mon projet, j'ai un premier Makefile qui en lance un second qui en lance un Cmake, chaque fichier | + | Cependant dans mon projet, j'ai un premier Makefile qui en lance un second qui en lance un Cmake, chaque fichier contient 400 lignes. Je n'avais pas vraiment la main pour ajouter cette librairie. J'ai fait pas mal de recherches et j'ai étudié tous les fichiers sans trouver comment ajouter cette librairie. J'ai alors repris le [[https://github.com/EAIBOT/ydlidar git]] du LIDAR et j'ai tout repris depuis le départ. Lorsqu'on clone le projet, il faut créer le dossier build, et lancer cette commande lorsqu'on se situe dans le dossier. |

cmake ../sdk | cmake ../sdk | ||

| − | Le fichier CMakeLists.txt était le seul que je n'avais pas | + | Le fichier CMakeLists.txt était le seul que je n'avais pas étudié. C'est donc dans ce fichier qu'il faut rajouter la ligne: |

target_link_libraries(ydlidar_driver ljsoncpp) | target_link_libraries(ydlidar_driver ljsoncpp) | ||

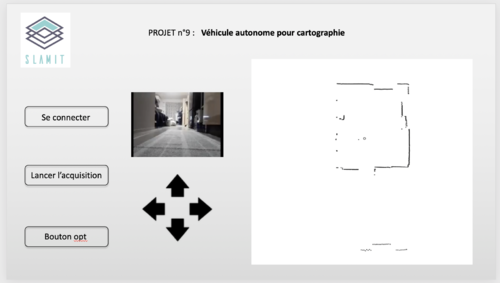

| + | ===Croquis du site final=== | ||

| − | + | Voici un croquis du site que je souhaite réaliser : | |

| − | |||

| − | |||

| − | Voici un croquis du site que je souhaite réaliser: | ||

[[Fichier:P9_Site SLAMiT.png|center |500 px| Croquis du site ]] | [[Fichier:P9_Site SLAMiT.png|center |500 px| Croquis du site ]] | ||

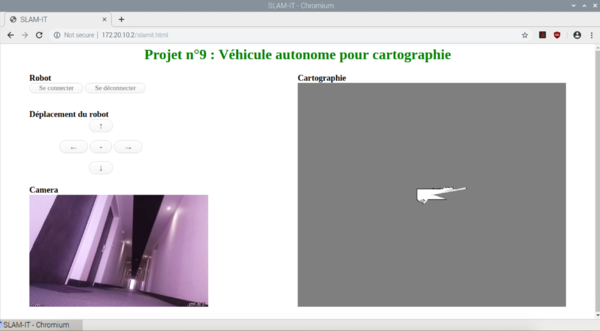

| − | Depuis la création du projet, j'ai choisi le nom du robot: SLAMiT. SLAM (simultaneous localization and mapping) fait référence à la cartographie et la localisation | + | Depuis la création du projet, j'ai choisi le nom du robot: SLAMiT. SLAM (simultaneous localization and mapping) fait référence à la cartographie et la localisation simultanée. |

| − | |||

| − | |||

| + | L'objectif serait d'avoir une interface simple dans un premier temps, qui permettrait de : | ||

| + | |||

* Voir le retour caméra du robot | * Voir le retour caméra du robot | ||

* Utiliser des flèches pour déplacer le robot à distance | * Utiliser des flèches pour déplacer le robot à distance | ||

| Ligne 573 : | Ligne 932 : | ||

Exemple d'utilisation : | Exemple d'utilisation : | ||

| − | L'utilisateur se rend sur la page du projet, il se connecte au robot avec le bouton n°1. Il voit alors le retour de la caméra du robot, et il peut aussi déplacer le robot. Lorsqu'il appuie sur lancer l'acquisition, il doit avoir la cartographie avec le point O qui représente la localisation du robot dans sa cartographie. Le but serait de superposer les | + | L'utilisateur se rend sur la page du projet, il se connecte au robot avec le bouton n°1. Il voit alors le retour de la caméra du robot, et il peut aussi déplacer le robot. Lorsqu'il appuie sur lancer l'acquisition, il doit avoir la cartographie avec le point O qui représente la localisation du robot dans sa cartographie. Le but serait de superposer les cartographies pour avoir un rendu précis et régler le problème des angles morts. |

| + | |||

| + | ==Semaine 7 : 21 Octobre - 3 Novembre == | ||

| + | |||

| + | Les objectifs de la 7ème semaine et la semaine de la Toussaint sont les suivants : | ||

| + | |||

| + | * Réaliser une première version du site en suivant l'idée du croquis | ||

| + | * Lancer l'acquisition de la cartographie à distance | ||

| + | * Déplacer le robot à distance | ||

| + | |||

| + | |||

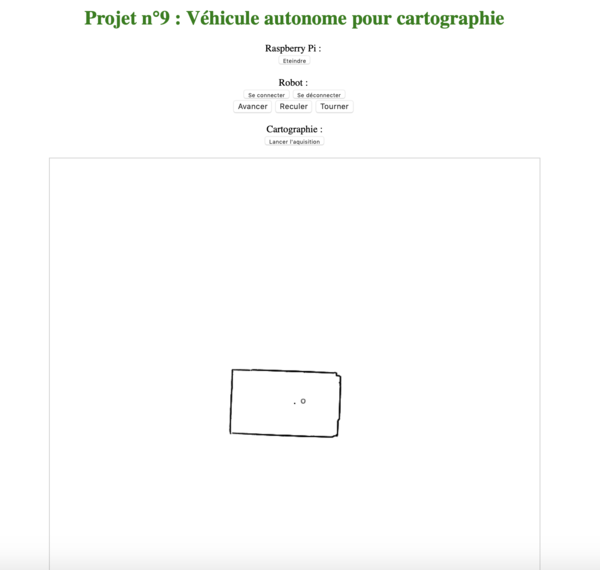

| + | === Réalisation du site === | ||

| + | |||

| + | Voici une image du site: | ||

| + | |||

| + | [[Fichier:P9_Site.png|center|600px]] | ||

| + | |||

| + | Dans un premier temps, je ne m'intéresse pas au design du site. Je préfère travailler le fond avant la forme. | ||

| + | * Concernant la Raspberry Pi : | ||

| + | :: '''Eteindre''' : | ||

| + | :::: Etant donné que je travaille maintenant à distance avec la RP, je dois l'arrêter proprement en exécutant la commande suivante 'sudo shutdown now ' | ||

| + | |||

| + | |||

| + | |||

| + | * Concernant le robot, il y a 5 boutons: | ||

| + | :: '''Se connecter et se déconnecter''': | ||

| + | :::: Le titre de la page permet d'avoir des informations sur cette connexion. S'il est vert, la connexion est établie, sinon il faut cliquer sur le bouton 'se connecter'. Si l'on souhaite se déconnecter au robot, il faut cliquer sur le bouton 'se déconnecter', le titre devient alors rouge. | ||

| + | :: '''Déplacement du robot''' : | ||

| + | :::: Il y a trois boutons pour le moment 'Avancer', 'Reculer', 'Tourner'. Ils permettront de commander le robot à distance. | ||

| + | |||

| + | |||

| + | * Concernant la cartographie : | ||

| + | :: '''Lancer l'acquisition''' : | ||

| + | :::: Le fonctionnement de ce bouton est expliqué dans la partie suivante [[https://projets-ima.plil.fr/mediawiki/index.php/IMA5_2019/2020_P09#Lancer_l.27acquisition_.C3.A0_distance 4.5.2]]. | ||

| + | |||

| + | === Cartographie === | ||

| + | |||

| + | Le lancement de la cartographie la semaine dernière fonctionnait, mais il affichait le résultat de l'exécution du fichier PHP. | ||

| + | Il faudrait maintenant que lorsque l'utilisateur appuie sur le bouton 'Lancer l'acquisition' : | ||

| + | * En arrière-plan : exécution du fichier .php qui permet au LIDAR de se lancer et d'enregistrer les données dans un fichier JSON | ||

| + | * Cette exécution en arrière-plan doit permettre à l'utilisateur de rester sur la page du site | ||

| + | * Lorsque le fichier est prêt le site affiche automatiquement la nouvelle cartographie. | ||

| + | |||

| + | === Déplacement du robot === | ||

| + | |||

| + | Pour permettre la communication entre le robot (Arduino) et la Raspberry Pi, je vais utiliser des Websockets. | ||

| + | C'est un protocole qui permet de développer un canal de communication sur un socket TCP. Il permet donc d’ouvrir une connexion permanente entre le navigateur et le serveur. | ||

| + | |||

| + | * Code HTML | ||

| + | |||

| + | var localhost = '127.0.0.1:9000'; | ||

| + | var ip_raspberry = '192.168.0.20:9000'; | ||

| + | var websocket=new WebSocket('ws://'+ip_raspberry,'serial'); | ||

| + | websocket.onopen=function(){ $('h1').css('color','green'); }; | ||

| + | websocket.onerror=function(){ $('h1').css('color','red'); }; | ||

| + | |||

| + | Les deux dernières lignes permettent d'informer l'utilisateur de la page | ||

| + | ::- Si le titre est vert => la connexion entre le navigateur et la Raspberry Pi est fonctionnelle | ||

| + | ::- Le titre sera rouge dans le cas contraire. | ||

| + | |||

| + | * Code C | ||

| + | |||

| + | J'ai eu l'occasion de travailler sur les websockets pour mon projet d'IMA3. J'ai récupéré le fichier C | ||

| + | |||

| + | Cf Git | ||

| + | |||

| + | == Semaine 8 - 11 : Mois Novembre == | ||

| + | |||

| + | === Deuxième site : Distance === | ||

| + | J'ai réalisé un deuxième site sur le serveur de la Raspberry Pi. Le but de ce site est de récupérer les valeurs des distances dans le canvas. | ||

| + | |||

| + | [[Fichier:P9_siteN2_distance.png]] | ||

| + | |||

| + | Ce deuxième permet à l'utilisateur d'avoir plus d'interactions avec la cartographie réalisée. En effet, lorsque l'utilisateur déplace la souris sur la cartographie, il obtient directement la valeur de la distance entre le pointeur et la position du robot. | ||

| + | Pour ce faire, je garde le premier canvas où la cartographie est affichée, et j'en rajoute un second ou j'affiche du texte : | ||

| + | <canvas id="myCanvas2" width="200" height="30" style="border:1px solid #d3d3d3;"></canvas> | ||

| + | |||

| + | J'obtiens la position du curseur avec la fonction suivante : | ||

| + | function getMousePos(canvas, evt) { | ||

| + | var rect = canvas.getBoundingClientRect(); | ||

| + | return { | ||

| + | x: evt.clientX - rect.left, | ||

| + | y: evt.clientY - rect.top | ||

| + | }; | ||

| + | } | ||

| + | |||

| + | Le message que j'affiche est obtenu de cette façon : | ||

| + | var mousePos = getMousePos(c, evt); | ||

| + | var xA = (mousePos.x - 400)/40; | ||

| + | var yA = (mousePos.y - 400)/40; | ||

| + | var distanceA = 'Distance : ' + Math.sqrt(Math.pow(xA,2)+Math.pow(yA,2)); | ||

| + | |||

| + | |||

| + | |||

| + | Je réduis la position x et y de 400 pour avoir la valeur en fonction de l'origine (position du robot). Je divise par 40 parce que mon canvas mesure 800 px et permet de représenter 10m de chaque côté donc 800/20=40. | ||

| + | |||

| + | <gallery mode="packed-hover"> | ||

| + | Image:P9_formule_distance.png | ||

| + | Image:P9_formule_distance_info.png | ||

| + | |||

| + | </gallery> | ||

| + | |||

| + | === Open CV === | ||

| + | |||

| + | Comme l'affichage des données est fonctionnel sur le site, j'ai cherché une façon d'exploiter mes résultats. J'ai choisi de creuser du côté du langage python parce qu'il possède une bibliothèque graphique libre pour le traitement d'images en temps réel. N'ayant pas de connaissance dans le domaine de Computer Vision, je me suis dans un premier temps fortement inspiré des codes déjà rédigés sur le site [https://www.pyimagesearch.com/ suivant] : | ||

| + | |||

| + | ==== Affichage de la cartographie ==== | ||

| + | J'ai codé un premier code, qui permet de récupérer un fichier JSON et de placer les points en fonction de l'angle et de la distance. J'ai gardé le même principe que l'affichage des données en Javascript. | ||

| + | |||

| + | [[Fichier:P9_printcanvas.png|center|500px]] | ||

| + | |||

| + | Sur cette photo, j'ai mis en parallèle une première cartographie, puis une seconde après le déplacement du robot dans la pièce. Le but est de pouvoir par la suite comparer deux versions afin de les superposer. | ||

| + | |||

| + | Extrait du code | ||

| + | |||

| + | J'utilise ces bibliothèques : | ||

| + | import math '''// Pour avoir les fonctions Cos et Sin''' | ||

| + | import matplotlib.pyplot as plt '''//Pour créer le graphique (=Cartographie)''' | ||

| + | import json '''// Pour récupérer le fichier JSON''' | ||

| + | from dataclasses import dataclass '''// Pour créer une classe Point''' | ||

| + | |||

| + | '''Voila la classe que j'ai codé qui me permet de définir un point avec les deux valeurs récupérées dans le fichier JSON''' | ||

| + | @dataclass | ||

| + | class P_Point: | ||

| + | distance: float | ||

| + | angle: float | ||

| + | '''Fonction qui permet de récupérer les données du fichier et de les ajouter dans un tableau de P_Point''' | ||

| + | def get_data(file, tb): | ||

| + | with open(file) as json_file: | ||

| + | data = json.load(json_file) | ||

| + | for value in data: | ||

| + | if (data[value]['distance'] != "0.000000" ): | ||

| + | p= P_Point(float (data[value]['distance']),float (data[value]['angle'])) | ||

| + | tb.append(p) | ||

| + | '''Fonction qui permet d'afficher les points dans le graphique''' | ||

| + | def plot_point(angle, length): | ||

| + | endy = length * math.sin(math.radians(angle)) | ||

| + | endx = length * math.cos(math.radians(angle)) | ||

| + | ax = plt.subplot(111) | ||

| + | ax.plot([0, endx], [0, endy]') | ||

| + | plt.plot(0,0, color ="red", marker='.', linestyle='dashed', linewidth=5, markersize=10) | ||

| + | |||

| + | J'arrive aux mêmes résultats que l'affichage sur le site du projet, il faut maintenant exploiter la cartographie. | ||

| + | |||

| + | |||

| + | ==== Tracé des murs ==== | ||

| + | |||

| + | Pour tracer les murs, j'ai pensé à : | ||

| + | * Reconnaître la forme de la pièce, | ||

| + | * Relier les points récupérés par le LIDAR, | ||

| + | |||

| + | Mais le premier affichage de la cartographie ne donne rien. Python ne reconnaît pas les formes parce qu'il y a des endroits sans informations. | ||

| + | |||

| + | {| class="wikitable" | ||

| + | |+ Comparaison des résultats | ||

| + | |- | ||

| + | ! scope="col" | Résultats | ||

| + | ! scope="col" | Commentaires | ||

| + | |- | ||

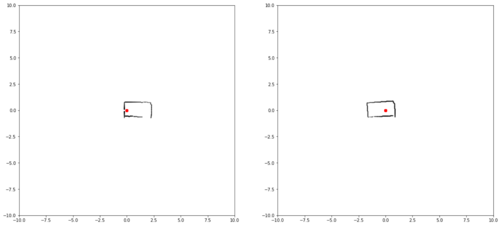

| + | | [[Fichier:P9_relierPoints.png|center|500px]] | ||

| + | | Comme on peut voir sur l'image, les informations ne sont pas exploitables. J'ai donc changé la façon d'afficher les données en copiant l'affichage de ROS. Le principe serait de mettre un fond gris, et de tracer des lignes blanche entre la position du robot et l'obstacle détecté, voici le rendu du deuxième affichage ci-dessous. | ||

| + | |- | ||

| + | |[[Fichier:P9_printcanvasGray.png|center|500px]] | ||

| + | | Comme on peut voir, les endroits sans informations sont parfois complétés, et j'arrive maintenant à reconnaitre les formes afin de tracer les contours de la pièce. | ||

| + | |- | ||

| + | |[[Fichier:P9_printcanvasShape.png|center|500px]] | ||

| + | | Il reste à lisser les contours pour corriger les éventuelles erreur du LIDAR. J'ai trouvé une thèse intéressante à ce sujet sur le site [https://dumas.ccsd.cnrs.fr/dumas-01334205/document suivant], voici quelques résultats de leurs recherches sur la photo ci-dessous. | ||

| + | |- | ||

| + | | [[Fichier:P9_TheseContour.png|center|550px]] | ||

| + | | Je trouve le résultat assez impressionnant, je pourrai reprendre l'idée pour combler le manque d'information et lisser les contours des pièces. | ||

| + | |} | ||

| + | |||

| + | ==== Recherche de similitudes ==== | ||

| + | |||

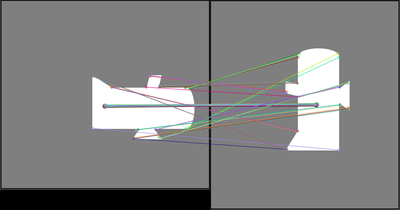

| + | Afin de pouvoir superposer deux cartographies, je dois trouver des keypoints communs aux deux photos. Pour y arriver je vais utiliser un outil disponible en Python qui est SURF, SIRF, et OBO. | ||

| + | Pour comprendre comment fonctionne SURF j'ai regardé deux tutoriels sur YouTube : | ||

| + | |||

| + | * [https://www.youtube.com/watch?v=USl5BHFq2H4&list=PL6Yc5OUgcoTmTGACTa__vnifNA744Cz-q&index=25 Feature detection (SIFT, SURF, ORB) ] | ||

| + | * [https://www.youtube.com/watch?v=Fe-KWKPk9Zc&list=PL6Yc5OUgcoTmTGACTa__vnifNA744Cz-q&index=26 Feature Matching (Brute-Force) – OpenCV 3.4 with python 3 Tutorial 26] | ||

| + | |||

| + | Le code de cette partie se trouve ici : [https://pysource.com/2018/03/23/feature-matching-brute-force-opencv-3-4-with-python-3-tutorial-26/ Lien]. | ||

| + | |||

| + | |||

| + | '''Comment fonctionne-t-il ?''' | ||

| + | |||

| + | ... | ||

| + | |||

| + | |||

| + | '''Voici le résultat de mes tests/ recherches:''' | ||

| + | |||

| + | J'ai remarqué que plus il y a d'informations sur les deux photos, plus python détecte des keypoints. Le principe de SURF est de comparer les keypoints des deux photos et regarder s'il y a des similitudes. | ||

| + | Donc si les photos représentent seulement un rectangle par exemple, SURF a du mal à traiter les photos. | ||

| + | |||

| + | |||

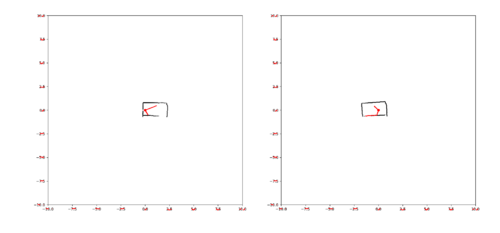

| + | {| class="wikitable" | ||

| + | |+ Comparaison des résultats | ||

| + | |- | ||

| + | ! scope="col" | Résultats | ||

| + | ! scope="col" | Commentaires | ||

| + | |- | ||

| + | | [[Fichier:P9_SURF1.png|center|400px]] | ||

| + | | Comme on peut voir sur cette image, Python n'a détecté que 2 Keypoints et ils sont faux ! | ||

| + | |- | ||

| + | |[[Fichier:P9_SURF2.png|center|400px]] | ||

| + | | J'ai essayé avec deux cartographies, on peut voir que le résultat s'améliore puisqu'il y a beaucoup plus d'informations. Cependant il reste quelques erreurs (1 seule: ligne violette). | ||

| + | |- | ||

| + | | [[Fichier:P9_SURF3.png|center|400px]] | ||

| + | | J'ai créé une forme avec beaucoup d'informations pour voir le résultat, on remarque à nouveau beaucoup de keypoints détectés et une fois de plus il n'y en a qu'un seul qui est faux. | ||

| + | |- | ||

| + | | [[Fichier:P9_SURF4.png|center|400px]] | ||

| + | | J'ai pivoté une des deux photos, le résultat est impressionnant! Malgré la rotation, il y a toujours autant de keypoints et ils sont presque tous justes ! | ||

| + | |} | ||

| + | |||

| + | === ROS === | ||

| + | |||

| + | Comme dit précédemment, son installation est impossible sur la RP3 qui n'a que 1GB de RAM. Bonduelle m'a fourni la RP4 (4GB), j'ai donc réessayé l'installation de ROS. Après de longues heures d'installations et de nombreux problèmes qu'il fallait régler. '''L'installation fonctionne et ROS démarre !! ''' | ||

| + | Comme je l'ai fait sur trois RP, les problèmes sont récurrents, et aucun tutoriel sur internet n'est complet. Je vais donc en rédiger un, il servira à Bonduelle et aux autres étudiants qui travailleront sur RP4 avec ROS. | ||

| + | |||

| + | [[Fichier:P9_ROS_Instructions.pdf]] | ||

| + | |||

| + | Configuration de ROS : | ||

| + | |||

| + | - '''Version''' : Mélodic | ||

| + | |||

| + | - '''Packages''' : | ||

| + | * Ylidar : [[https://github.com/EAIBOT/ydlidar GItHub Ylidar ]] | ||

| + | |||

| + | * Hector : [[https://github.com/tu-darmstadt-ros-pkg/hector_slam Github Hector ]] | ||

| + | |||

| + | Pour lancer la cartographie, il faut ouvrir trois onglets du terminal avec les commandes suivantes : | ||

| + | |||

| + | {| class="wikitable" | ||

| + | |- | ||

| + | |$ ''roscore'' | ||

| + | | C’est le noeud qui prépare le système ROS, il accepte les commandes. ROS est un système centralisé, un nœud maître (roscore) est toujours nécessaire pour les autres nœuds et doit être exécuté avant les autres nœuds. Roscore démarre ce noeud principal. | ||

| + | |- | ||

| + | | $ ''roslaunch ylidar lidar.launch '' | ||

| + | | Permet de démarrer l'acquisition des données du Lidar | ||

| + | |- | ||

| + | | $ ''roslaunch hector_slam_launch tutorial.launch '' | ||

| + | | Permet de démarrer Rviz et affiche les résultats du LIDAR en temps réel. | ||

| + | |} | ||

| + | |||

| + | Voici le résultat chez moi : | ||

| + | |||

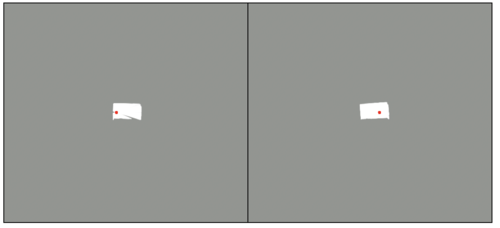

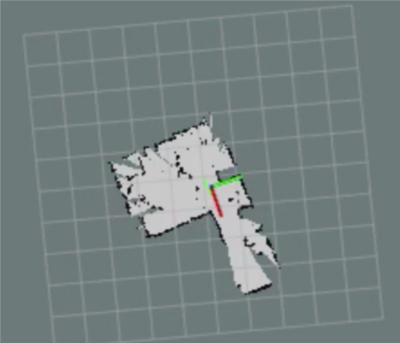

| + | {| class="wikitable" | ||

| + | |- | ||

| + | |Sans Hector : ROS + YLIDAR | ||

| + | | [[Fichier:P9_ROS_HECTOR1.png|center|400px]] | ||

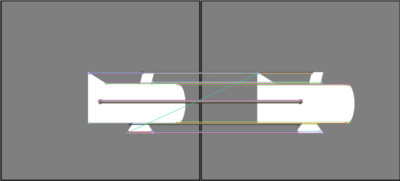

| + | | On peut voir que cette version s'apparente beaucoup à ce que j'obtiens sur le site du projet. ROS positionne seulement les points en fonction de l'angle et de la distance.. La seule différente non négligeable avec mon programme c'est le programme tourne en temps réel, donc les points s'actualisent si l'environnement a changé. | ||

| + | |- | ||

| + | | Avec Hector : ROS + YLIDAR + HECTOR | ||

| + | | [[Fichier:P9_ROS_HECTOR2.png|center|400px]] | ||

| + | | Dans cette version, ROS trace les murs en noir et trace le chemin parcouru en vert. Les deux lignes verte et rouge permettent de situer le robot dans la pièce. Cette version s'actualise en Temps réel aussi. | ||

| + | |} | ||

| + | |||

| + | ==Semaines 12 & 13 : 2 - 15 Décembre == | ||

| + | |||

| + | === Point avec Bonduelle : Modification === | ||

| + | |||

| + | J'ai présenté mon avancement à Xavier CHENOT et Erwan NIQUET. | ||

| + | Ils sont satisfaits de mon avancement, mais ils préfèrent que je me concentre seulement sur ROS. Ils pensent que c'est exactement l'outil qu'ils envisagent pour ce projet. Donc il faut que je trouve un outil qui permet d'enregistrer les données de la cartographie en temps réel, afin de les afficher sur le site du projet. | ||

| + | |||

| + | A la place de la recherche sur OpenCv, Erwan propose d'ajouter en fonction de l'avancement de mon projet en mi-janvier/ février du machine Learning. Pour le permettre sur la RP4, ils ont acheté [https://coral.ai/products/accelerator Coral] c'est un USB Accelerator. | ||

| + | |||

| + | [[Fichier:P9_Coral.jpg|center|400px]] | ||

| + | ''' | ||

| + | === ROS === | ||

| + | |||

| + | |||

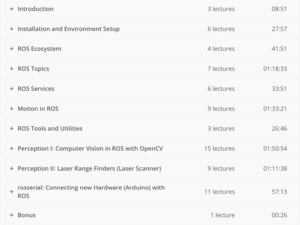

| + | Etant donné que je vais totalement me concentrer sur ROS pour la suite du projet, j'ai choisi de me former à l'aide du site Udemy. Voici le lien du cours que je suis : https://www.udemy.com/course/ros-essentials/ | ||

| + | |||

| + | [[Fichier:P9_ROS_UDEMY.png|300px|center]] | ||

| + | |||

| + | |||

| + | J'ai également regardé les trois vidéos suivantes : [https://www.youtube.com/watch?v=oS0C1ZYvY6Y 1], [https://www.youtube.com/watch?v=Q4qM-Uzj1SI 2] et [https://www.youtube.com/watch?v=htE5cClSy4Y 3]. Ce sont des cours concernant ROS et plus précisément Hector SLAM, elles ont été réalisées par Paritosh Kelkar un diplômé de l'université de Pennsylvanie. | ||

| + | |||

| + | |||

| + | Ces cours m'ont vraiment aidés à mieux comprendre comment fonctionne ROS, ce qui m'a permis d'avancer dans mon projet. | ||

| + | |||

| + | |||

| + | ====Enregistrer des données de cartographie ==== | ||

| + | rosbag record -a | ||

| + | |||

| + | Cette commande permet d'enregistrer toutes les données en cours dans un format '.bag'. Il faut maintenant savoir comment les extraire pour les analyser. | ||

| + | |||

| + | |||

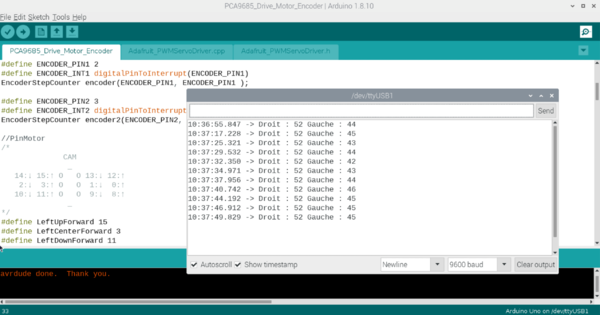

| + | ====ROS Serial==== | ||

| + | Grâce aux cours que j'ai suivi, j'ai appris qu'il était possible de dialoguer en communication série entre Arduino et ROS. | ||

| + | |||

| + | cd <ws>/src | ||

| + | git clone https://github.com/ros-drivers/rosserial.git | ||

| + | cd .. | ||

| + | catkin_make | ||

| + | |||

| + | <ws> est le répertoire catkin_ws. | ||

| + | |||

| + | Il faut ensuite se déplacer dans le dossier des libraires d'Arduino, pour ajouter la librairie de ROS: | ||

| + | |||

| + | cd <sketchbook>/libraries | ||

| + | rm -rf ros_lib | ||

| + | rosrun rosserial_arduino make_libraries.py . | ||

| + | Une fois la libraire ajoutée, il faut ouvrir Arduino, 'File', 'Example' et choisir dans un exemple depuis ros_lib. | ||

| + | |||

| + | =====Hello World===== | ||

| + | Dans un premier temps, j'ai choisi l'exemple 'Hello World' que j'ai téléversé. J'ai ouvert trois terminaux sur le bureau de la RP4 avec les commandes suivantes: | ||

| + | |||

| + | {| class="wikitable" | ||

| + | |- | ||

| + | ! scope="col" | Terminal 1 | ||

| + | ! scope="col" | Terminal 2 | ||

| + | |- | ||

| + | | ''roscore'' | ||

| + | | ''rosrun roserial-python serial_node.py /dev/ttyUSB1'' | ||

| + | Permet d'établir la communication série avec le port ttyUSB1 => Arduino | ||

| + | |- | ||

| + | ! Terminal 3 | ||

| + | ! | ||

| + | |- | ||

| + | | ''rostopic echo /chatter'' | ||

| + | Affiche les messages envoyés par l'arduino (≃ minicom) | ||

| + | | | ||

| + | |} | ||

| + | |||

| + | Dans ce premier exemple, l'Arduino joue le rôle de Publisher et ROS le rôle de Subscriber. Le second exemple que j'ai suivi est 'Blink', son code permet de changer l'état d'un LED lorsque l'Arduino reçoit un message vide. | ||

| + | |||

| + | =====Blink Led ===== | ||

| + | {| class="wikitable" | ||

| + | |- | ||

| + | ! scope="col" | Terminal 1 | ||

| + | ! scope="col" | Terminal 2 | ||

| + | |- | ||

| + | | ''roscore'' | ||

| + | | ''rosrun roserial-python serial_node.py /dev/ttyUSB1'' | ||

| + | Permet d'établir la communication série avec le port ttyUSB1 => Arduino | ||

| + | |- | ||

| + | ! Terminal 3 | ||

| + | ! | ||

| + | |- | ||

| + | | ''rostopic pug toggle_led std_msgs/Empty --once'' | ||

| + | Permet d'envoyer un message vide sur la liaison série . | ||

| + | | | ||

| + | |} | ||

| + | Dans ce second exemple, l'Arduino joue le rôle de Subscriber et ROS le rôle de Publisher, parce que c'est un des noeuds de ROS qui envoie un message et c'est Arduino qui attend/écoute. Dans cet exemple, l'arudino attend un message vide. J'ai modifié le code pour qu'il attende la valeur 2. La commande du terminal 3 devient alors : | ||

| + | rostopic pug toggle_led std_msgs/Int32 2 --once | ||

| + | |||

| + | =====Déplacement du robot===== | ||

| + | |||

| + | Le robot est commandé à distance depuis le site du projet, pour y arriver j'utilise des websockets qui envoient des données en liaison série à l'arduino. Lorsqu'il reçoit '1' le robot avance, lorsqu'il reçoit '2', le robot recule et il tourne lorsqu'il reçoit '3'. J'ai donc continué la modification du code Blink pour faire apparaitre ces conditions. | ||

| + | <span style="color:green">J'arrive à présent à déplacer mon Robot en utilisant ROS.</span> | ||

| + | |||

| + | ==Semaine 14 : 16 - 22 Décembre (Soutenance 1) == | ||

| + | |||

| + | |||

| + | |||

| + | Voici un aperçu de l'avancement de mon projet en vidéo: | ||

| + | |||

| + | [[Fichier:P9_video1.mp4|320x320px|center]] | ||

| + | |||

| + | Dans un premier temps, je lance ROS : | ||

| + | * roscore | ||

| + | * roslaunch ydlidar lidar.launch | ||

| + | * roslaunch hector_slam tutorial.launch | ||

| + | |||

| + | Ensuite, je permets la communication entre mon site => la Raspberry Pi => et le Robot (Arduino) à l'aide des websockets. | ||

| + | |||

| + | On peut enfin voir, que lorsque le robot se déplace la cartographie se construit en même temps. | ||

| + | |||

| + | ==Semaines 15 - 16 : 6 - 19 janvier == | ||

| + | |||

| + | === Problème de shift === | ||

| + | La vidéo de la rubrique précédente montre que la cartographie fonctionne très bien lorsque qu'il avance en ligne droite. J'ai fait d'autres tests lorsque le robot tourne, voici le résultat : | ||

| + | [[Fichier:P9_navigation_shift.gif|center|800px]] | ||

| + | |||

| + | Ce problème est dû à des mouvements brusques du robot, lorsqu'il va trop vite : le phénomène de shift. Cela arrive souvent lorsque le robot tourne de façon trop rapide. | ||

| + | Mais c'est également dû au fait que le robot n'est pas "solide". Lorsqu'il avance avec une vitesse importante et qu'il freine subitement, la plateforme sur laquelle est fixée le Lidar ne reste pas parallèle au sol. C'est à cause des suspensions de mauvaise qualité, le lidar qui est placé sur le robot change de position et ne reste pas vraiment horizontal. | ||

| + | |||

| + | === Autre piste de recherche : Exploitation des données du fichier .bag === | ||

| + | |||

| + | Lorsque je cherchais à enregistrer les données de la cartographie, j'ai réussi à enregistrer un fichier sous le format .bag. En faisant des recherches sur internet, j'ai trouvé un script qui permet de convertir un fichier . bag en un fichier .csv. Je garde en tête cette piste, si je n'arrive pas déporté Vos sur mon site Web. | ||

| + | |||

| + | === Contrôle à distance de la Rapberrypi === | ||

| + | |||

| + | Depuis le début de ce projet, j'utilise le desktop de la RP plutôt que son contrôle uniquement par ligne de commandes en shh. L'un des inconvénients majeurs était que je devais toujours avoir un câble HMDI qui reliait le robot à un écran, mais ce n'est pas pratique lorsqu'on souhaite que le robot se déplace dans une pièce. | ||

| + | |||

| + | '''Screen Recorder''' | ||

| + | |||

| + | Dans un premier temps, j'ai travaillé en effectuant des enregistrements vidéos de mon écran avec l'application lorsqu'il n'était pas branché à mon écran. Ca fonctionne mais ce n'est pas pratique. | ||

| + | sudo apt-get update | ||

| + | sudo apt-get install simplescreenrecorder | ||

| + | |||

| + | '''Export d'affichage par SSH''' | ||

| + | |||

| + | Ensuite, j'ai fait des recherches pour pouvoir me connecter en ssh à la RP mais avec l'affichage graphique. | ||

| + | ssh -X -Y pi@172.20.10.2 | ||

| + | J'ai réussi à afficher mon bureau à distance sur mon ordinateur, mais lorsque je lançais ROS (RViz), j'avais un message d'erreur qui m'indiquait une incompatibilité du à un problème interne. Donc cette solution n'est pas envisageable. | ||

| + | |||

| + | '''Serveur VNC''' | ||

| + | |||

| + | Enfin, j'ai essayé une dernière solution : screen sharing depuis un Mac. | ||

| + | '''Sur la RP :''' | ||

| + | Menu > Raspberry Pi Configuration > Activer VNC | ||

| + | Une fois que la raspberry a redémarré, une icône VNC est visible sur la barre du menu. Il faut la sélectionner : | ||

| + | '''Sur RP - VNC :''' | ||

| + | Menu > Options > Sécurité | ||

| + | Encryption = Prefer off | ||

| + | Authentication = VNC Password | ||

| + | Enfin il faut choisir un mot de passe. | ||

| + | |||

| + | '''Sur le Mac''' : | ||

| + | Il faut ouvrir l'application Partage d'écran et entrer l'adresse IP de la RP et le mot de passe qui a été crée dans les paramètres de VNC. | ||

| + | Macintosh HD ▸ Système ▸ Bibliothèque ▸ CoreServices ▸ Applications ▸ Partage d'écran (en Français ou Screen Sharing en Anglais). | ||

| + | |||

| + | [[Fichier:P9_DesktopRPI.png|center|400px]] | ||

| + | |||

| + | <span style="color:green"> J'ai donc réussi avec cette dernière option à contrôler à distance la RP et à lancer ROS depuis mon mac ! </span> | ||

| + | |||

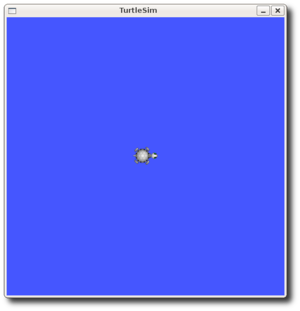

| + | === Formation ROS Turtlebot === | ||

| + | TurtleBot est un kit de robot avec un logiciel open source. TurtleBot a été créé au Willow Garage par Melonee Wise et Tully Foote en novembre 2010. Ce robot est capable de circuler dans votre maison, de voir en 3D la carte de la pièce. L'objectif de cette formation est de pouvoir rendre mon robot compatible avec ROS et donc de pouvoir le contrôler directement depuis la plateforme de ROS. | ||

| + | Voici la [https://github.com/ros/ros_tutorials/tree/melodic-devel/turtlesim page] où l'on trouve le dossier nécessaire. | ||

| + | Pour les personnes n'ayant pas le robot Turtlebot, il existe une simulation. | ||

| + | Dans un premier temps, il faut lancer : | ||

| + | $ roscore | ||

| + | $ rosrun turtlesim turtlesim_node | ||

| + | |||

| + | [[Fichier:P9_turttlesim.png|center|300px]] | ||

| + | |||

| + | L'objectif à présent est de déplacer cette tortue dans son environnement. Il est tout à fait possible de la '''déplacer en utilisant les touches''' ( up, down, right et left) avec la commande ci dessous : | ||

| + | $ rosrun turtlesim turtle_teleop_key | ||

| + | Mais cela ne fonctionnera pas avec un vrai robot par la suite. Pour que ROS puisse contrôler un robot il envoie les coordonnées dans un message de type Twist : | ||

| + | geometry_msgs/Vector3 linear | ||

| + | geometry_msgs/Vector3 angular | ||

| + | C'est un message qui se compose de deux vecteurs, un vecteur linéaire avec trois valeurs et un second vecteur pour trois valeurs angulaires. | ||

| + | |||

| + | Il existe des limitations en ce qui concerne le robot: | ||

| + | * La navigation n'est possible que pour des robots "diferential drive" et des robots holonomiques. =><span style="color:blue"> '''J'ai donc besoin de rajouter des encodeurs à mes roues motrices.'''</span> | ||

| + | |||

| + | * Le robot reçoit un message de type twist avec des vitesses X, Y et Thêta qui lui permettent de se déplacer. Si le robot n'est pas en mesure de les comprendre, il est possible créer un nœud ROS qui convertit un message vers un autre de type twist. => '''<span style="color:blue"> Il faut comprendre le fonctionnement des ces vecteurs sur le déplacement du robot.'''</span> | ||

| + | |||

| + | |||

| + | Je vais donc opter pour le déplacement avec les deux vecteurs. J'ai fait des recherches concernant 'diferential drive' et je suis tombée sur ce [http://ais.informatik.uni-freiburg.de/teaching/ss17/robotics/exercises/solutions/03/sheet03sol.pdf site] qui explique bien le fonctionnement mathématique avec un corrigé d'un exercice. J'ai remarqué que seules deux valeurs sur les 6 sont utiles. X permet d'avancer d'une distance et θz permet de tourner de l'angle indiqué. | ||

| + | |||

| + | {| class="wikitable" | ||

| + | |- | ||

| + | ! Vecteur Linéaire | ||

| + | ! Vecteur angulaire | ||

| + | |- | ||

| + | | | ||

| + | '''x''' | ||

| + | |||

| + | y | ||

| + | |||

| + | z | ||

| + | | | ||

| + | θx | ||

| + | |||

| + | θy | ||

| + | |||

| + | '''θz''' | ||

| + | |} | ||

| + | |||

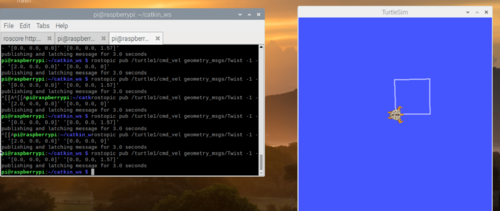

| + | Pour déplacer la tortue avec ce type de message : | ||

| + | $ rostopic pub /turtle1/cmd_vel geometry_msgs/Twist -1 -- '[ Xvalue, Yvalue, Zvalue ]' '[θXvalue, θYvalue, θZvalue ]' | ||

| + | |||

| + | Par exemple pour que le robot puisse se déplacer en réalisant la forme d'un carré, voici les commandes à réaliser quatre fois : | ||

| + | $ rostopic pub /turtle1/cmd_vel geometry_msgs/Twist -1 -- '[2,0,0]' '[0,0,0]' // Le robot avance de 2 | ||

| + | $ rostopic pub /turtle1/cmd_vel geometry_msgs/Twist -1 -- '[0,0,0]' '[0,0,1.57]' // Le robot tourne sur lui même de Pi/2 (=1.57) | ||

| + | |||

| + | [[Fichier:P9_turtle1_carre.png|center|500px]] | ||

| + | |||

| + | === Contrôle du robot avec ROS === | ||

| + | |||

| + | |||

| + | J'aimerai pour la suite du projet, pouvoir contrôler le robot avec l'interface graphique de ROS. Pour le moment je contrôle les moteurs du robot avec en imposant une valeur entre 0 et 255 à chaque roue. (Pour rappel, le robot est équipé de 6 moteurs à courant continu). | ||

| + | |||

| + | Avec ROS, la seule façon de contrôler un robot c'est en lui imposant les valeurs de vitesse x, y et θ. Mais je n'ai pas d'encodeur sur mes moteurs. Pour le moment, il faut que je trouve une solution pour contrôler mon robot en vitesse. | ||

| + | |||

| + | ==Semaines 17 et 18 : 20 Janvier - 2 février == | ||

| + | |||

| + | Comme dit précédemment, pour contrôler mon robot, j'ai besoin d'encodeurs sur les roues motrices. J'ai récupéré celui [https://www.ebay.com/itm/TinySine-Wheel-Encoder-Kit-for-Robot-Car/254430315819?hash=item3b3d3a852b:g:bM4AAOSwbv9d2Bxi ci] de chez Monsieur Redon. | ||

| + | |||

| + | === Encodeurs incrémentals === | ||

| + | |||

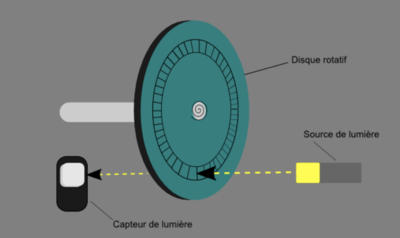

| + | La plupart des encodeurs pour robots mobiles utilisent des capteurs optiques. L’idée est de placer un disque alternant des zones transparentes (ou tout simplement des trous) et opaques (le disque lui-même) entre un capteur de lumière et un émetteur de lumière. Ce dernier se place sur l'axe de rotation de la roue. La fréquence d’apparition des zones blanches et noires devant le capteur de lumière va indiquer la vitesse de rotation. Le schéma suivant présente le principe de fonctionnement basique de l’encodeur : | ||

| + | [[Fichier:P9_encodeur.png|center|400px]] | ||

| + | |||

| + | === Modélisations=== | ||

| + | Le problème qui se pose est que je n'ai pas suffisamment de place pour positionner l'encodeur sur l'axe du moteur. | ||

| + | ==== > Modélisation 1 ==== | ||

| + | Dans un premier temps, j'ai modélisé une pièce 3D qui permettait de rallonger l'axe : (cf Modélisation 1) | ||

| + | Cette solution n'a pas fonctionnée parce que les valeurs sont tellement petites (0,3 cm de diamètre) que ça n'a pas abouti. L'imprimante 3D n'a pas une précision assez bonne. | ||

| + | |||

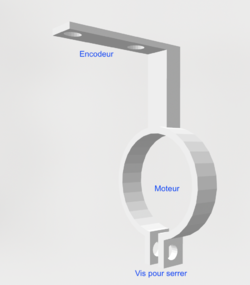

| + | ==== > Modélisation 2 ==== | ||

| + | J'ai ensuite modélisé deux pièces, un support pour accrocher l'encodeur à la structure du robot et une roue à la bonne échelle pour qu'elle puisse tenir sur l'axe des coupleurs plutôt que sur l'axe du moteur. (cf Modélisation 2) | ||

| + | |||

| + | Sur internet, il n y a pas de documentations concernant [https://www.ebay.com/itm/TinySine-Wheel-Encoder-Kit-for-Robot-Car/254430315819?hash=item3b3d3a852b:g:bM4AAOSwbv9d2Bxi cette] version d'encodeur. Mais il y a trois pins : | ||

| + | * 5V | ||

| + | * GRND | ||

| + | * OUT : Ce qui indique qu'il un signal dès que la lumière de la LED est reçue par le capteur de lumière. | ||

| + | |||

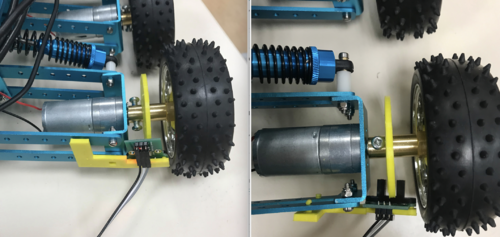

| + | Voici le rendu : | ||

| + | [[Fichier:P9_encodeur_robot.png|thumb|Montage|center|500px]] | ||

| + | J'ai imprimé les pièces en double afin de placer les encodeurs sur les deux roues à l'avant. | ||

| + | |||

| + | ==== > Modélisation 3 ==== | ||

| + | <span style="color:blue">'''[EDIT]''' </span>Après avoir testé plusieurs fois, les résultats n'étaient pas convaincants, ils manquent de précisions. A force de déplacer les roues du robots. le centre du disque de l'encodeur s'élargie, ce qui implique qu'il ne tourne plus en même temps que la roue. Cela fausse donc les résultats. L'autre pièce est aussi problématique puisqu'elle s'accroche directement sur les suspensions du robot. Ce choix n'était pas judicieux puisque le robot est très peu droit. | ||

| + | Il faut donc réaliser une nouvelle modélisation des pièces. (cf Modélisation 3) | ||

| + | |||

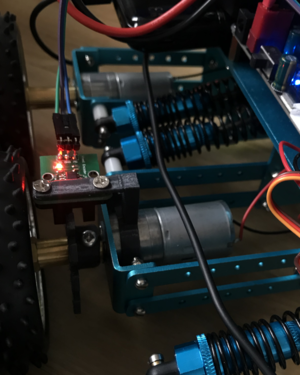

| + | Voici le rendu : | ||

| + | [[Fichier:P9_encodeur_robot2.png|thumb|Montage 2|center|300px]] | ||

| + | |||

| + | ==== Récapitulatif ==== | ||

| + | {| class="wikitable" | ||

| + | | style="width: 20%; background-color:#F1AAA4;" | Modélisation 1 | ||

| + | | style="width: 30%; background-color:#FECE7F;" | Modélisation 2 | ||

| + | | style="width: 30%; background-color:#BBF1A9;" | Modélisation 3 | ||

| + | |- | ||

| + | | | ||

| + | {| | ||

| + | |'''Rallonge axe moteur''' | ||

| + | [[Fichier:P9_encodeur_axe.png|center|200px]] | ||

| + | Le but était de modéliser une pièce qui permettrait d'allonger l'axe du moteur. Ce n'est pas réalisable parce que son diamètre est de 4 mm. Il est impossible d'atteindre une telle précision avec une imprimante 3D. | ||

| + | |} | ||

| + | | | ||

| + | {| | ||

| + | |'''Support encodeur''' | ||

| + | [[Fichier:P9_encodeur_support.png|Support de l'encodeur|left|200px]] | ||

| + | | Ce robot n'a pas été conçu pour avoir des encodeurs. Il n'y a pas de place pour les faire tenir. Sur les suspensions du robot, il y a des trous, je voulais en profiter pour accrocher le support de l'encodeur. | ||

| + | |- | ||

| + | |'''Disque de l'encodeur''' | ||

| + | [[Fichier:P9_encodeur_roue.png|Roue|center|200px]] | ||

| + | | Roue à la bonne échelle pour qu'elle puisse tenir sur l'axe des coupleurs plutôt que sur l'axe du moteur.J'ai pris leurs dimensions, mais à force, le disque centrale s'élargie et n'est plus stable ce qui engendre des erreurs de distance. | ||

| + | |} | ||

| + | | | ||

| + | {| | ||